Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

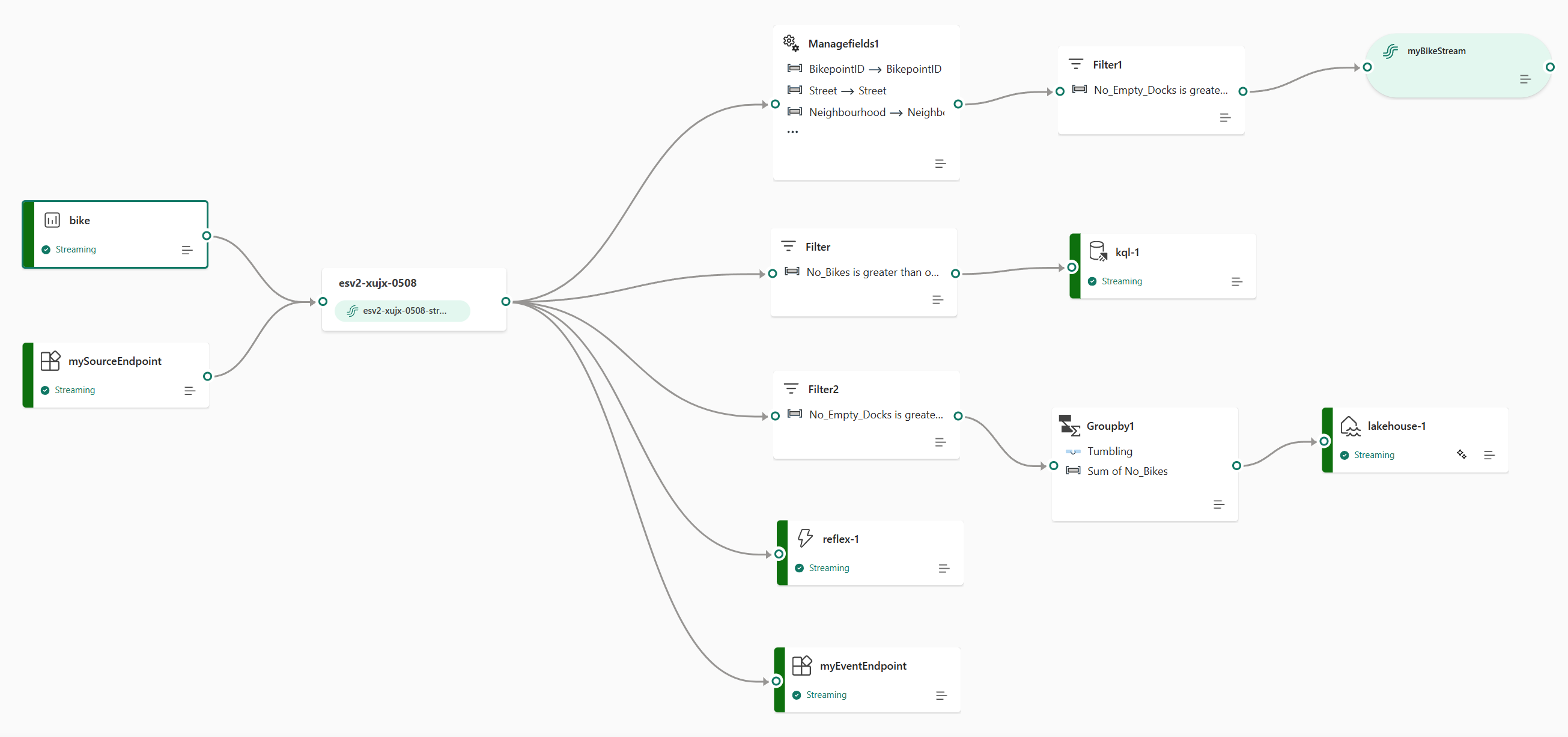

Вы можете использовать функцию потоков событий в Microsoft Fabric Real-Time Intelligence, чтобы перенести события реального времени в Fabric, преобразовать их, а затем перенаправить их в различные назначения без написания кода. Создайте поток событий, добавьте источники данных событий в поток, при необходимости добавьте преобразования для преобразования данных события, а затем перенаправьте данные в поддерживаемые назначения.

Кроме того, с конечными точками Apache Kafka, доступными для потоков событий, можно отправлять или использовать события в режиме реального времени с помощью протокола Kafka.

Добавление событий в Fabric

Потоки событий предоставляют исходные соединители для получения данных о событиях из различных источников. Дополнительные источники доступны при включении расширенных возможностей во время создания потока событий.

| Исходный материал | Описание |

|---|---|

| Azure Data Explorer (предварительная версия) | Если у вас есть база данных Azure Data Explorer и таблица, вы можете получать данные из таблицы в Microsoft Fabric с помощью eventstream. |

| Центры событий Azure | Если у вас есть концентратор событий Azure, вы можете получать данные концентратора событий в Microsoft Fabric с помощью Eventstream. |

| Сетка событий Azure (предварительная версия) | Если у вас есть пространство имен Azure Event Grid, вы можете получать данные событий MQTT или не MQTT в Microsoft Fabric с помощью Eventstream. |

| Служебная шина Azure (предварительная версия) | Вы можете получать данные из очереди Azure Service Bus или подписки темы в Microsoft Fabric с помощью Eventstream. |

| Центр Интернета вещей Azure | Если у вас есть Центр Интернета вещей Azure, вы можете получать данные Интернета вещей в Microsoft Fabric с помощью eventstream. |

| Пользовательская конечная точка (то есть пользовательское приложение в стандартных возможностях) | Функция настраиваемой конечной точки позволяет вашим приложениям или клиентам Kafka подключаться к Eventstream, используя строку подключения, обеспечивая плавную загрузку потоковых данных в Eventstream. |

| Операции Интернета вещей Azure | Настройте операции Интернета вещей Azure для отправки данных в режиме реального времени непосредственно в Microsoft Fabric Real-Time Intelligence с помощью настраиваемой конечной точки eventstream (поддерживает проверку подлинности Microsoft Entra ID или SASL). |

| Пример данных | Вы можете выбрать велосипеды, желтое такси, фондовый рынок, автобусы, S&P 500 компании акции или журналы семантической модели в качестве примера источника данных для проверки приема данных при настройке потока событий. |

| Погода в режиме реального времени (предварительная версия) | Вы можете добавить источник погоды в режиме реального времени в поток событий для потоковой передачи данных о погоде в режиме реального времени из разных расположений. |

| Фиксация изменений данных в базе данных Azure SQL (CDC) | Источник соединителя CDC для Базы данных SQL Azure позволяет сделать моментальный снимок текущих данных в Базе данных SQL Azure. Затем соединитель отслеживает и записывает любые будущие изменения на уровне строк в эти данные. |

| База данных PostgreSQL CDC | Коннектор захвата изменений данных (CDC) для источника позволяет захватывать моментальный снимок текущих данных в базе данных PostgreSQL. Затем соединитель отслеживает и записывает любые будущие изменения на уровне строк в эти данные. |

| CdC MongoDB (предварительная версия) | Источник CDC-подключения для потоков событий Microsoft Fabric фиксирует начальный моментальный снимок данных из MongoDB. Можно указать коллекции для мониторинга, а поток событий отслеживает и записывает изменения в документы в выбранных базах данных и коллекциях в режиме реального времени. |

| База данных MySQL CDC | Коннектор источника данных Change Data Capture (CDC) в Azure для MySQL позволяет записывать моментальный снимок текущих данных в базе данных Azure для MySQL. Таблицы можно указать для отслеживания, а поток событий записывает любые будущие изменения на уровне строк в таблицы. |

| Azure Cosmos DB CDC | Соединитель источника отслеживания изменений Azure Cosmos DB для потоков событий Microsoft Fabric позволяет получить снимок текущих данных в базе данных Azure Cosmos DB. Затем соединитель отслеживает и записывает любые будущие изменения на уровне строк в эти данные. |

| SQL Server на виртуальной машине (БД) CDC | Соединитель источника SQL Server на виртуальной машине (CDC) для потоков событий Fabric позволяет захватывать снимок текущих данных в базе данных SQL Server на виртуальной машине. Затем соединитель отслеживает и записывает любые будущие изменения на уровне строк в данные. |

| Управляемый экземпляр Azure SQL CDC | Соединитель источника CDC для Управляемого экземпляра SQL Azure для потоков событий Microsoft Fabric позволяет снимать моментальный снимок текущих данных в базе данных Управляемого экземпляра SQL. Затем соединитель отслеживает и записывает любые будущие изменения на уровне строк в эти данные. |

| События элемента рабочего пространства Fabric | События элементов рабочей области Fabric — это дискретные события Fabric, которые происходят при внесении изменений в рабочую область Fabric. Эти изменения включают создание, обновление или удаление элемента Fabric. С помощью потоков событий Fabric можно записывать эти события рабочей области Fabric, преобразовывать их и направлять их в различные назначения в Fabric для дальнейшего анализа. |

| События Fabric OneLake | События OneLake позволяют подписываться на изменения в файлах и папках в OneLake, а затем реагировать на эти изменения в режиме реального времени. С помощью потоков событий Fabric можно записывать эти события OneLake, преобразовывать их и направлять их в различные назначения в Fabric для дальнейшего анализа. Эта простая интеграция событий OneLake в потоках событий Fabric обеспечивает большую гибкость для мониторинга и анализа действий в OneLake. |

| события задания Fabric | События задания позволяют подписываться на изменения, которые происходят при выполнении задания в системе Fabric. Например, можно реагировать на изменения при обновлении семантической модели, выполнении запланированного конвейера или запуске записной книжки. Каждое из этих действий может создать соответствующее задание, которое, в свою очередь, создает набор соответствующих событий задания. С помощью потоков событий Fabric можно записывать эти события задания, преобразовывать их и направлять их в различные назначения в Fabric для дальнейшего анализа. Эта простая интеграция событий задания в потоках событий Fabric обеспечивает большую гибкость для мониторинга и анализа действий в задании. |

| События в Azure Blob Storage | События хранилища больших двоичных объектов Azure активируются, когда клиент создает, заменяет или удаляет двоичный объект. Соединитель позволяет связывать события хранилища Blob с событиями Fabric в хабе реального времени. Эти события можно преобразовать в непрерывные потоки данных и трансформировать их перед отправкой в различные места назначения в Fabric. |

| Google Cloud Pub/Sub | Google Pub/Sub — это служба обмена сообщениями, которая позволяет публиковать и подписываться на потоки событий. Вы можете добавить Google Pub/Sub в качестве источника в поток событий для отслеживания, преобразования и маршрутизации событий в режиме реального времени в различные места назначения в Fabric. |

| Потоки данных Amazon Kinesis | Amazon Kinesis Data Streams — это масштабируемая и высокопрочная служба приема и обработки данных, оптимизированная для потоковой обработки данных. Интеграция Amazon Kinesis Data Streams в качестве источника в потоке событий позволяет легко обрабатывать потоки данных в режиме реального времени перед маршрутизацией их в несколько назначений в Fabric. |

| Confluent Cloud для Apache Kafka | Confluent Cloud для Apache Kafka — это платформа потоковой передачи и обработки данных с помощью Apache Kafka. Интеграция Confluent Cloud для Apache Kafka в качестве источника в потоке событий позволяет легко обрабатывать потоки данных в режиме реального времени перед маршрутизацией их в несколько назначений в Fabric. |

| Apache Kafka (предварительная версия) | Apache Kafka — это распределенная платформа с открытым кодом для создания масштабируемых систем данных в режиме реального времени. Интегрируя Apache Kafka в качестве источника в потоке событий, вы можете легко перенести события в режиме реального времени из Apache Kafka и обработать их перед маршрутизацией их в несколько назначений в Fabric. |

| Amazon MSK Kafka | Amazon MSK Kafka — это полностью управляемая служба Kafka, которая упрощает настройку, масштабирование и управление. Интегрируя Amazon MSK Kafka в качестве источника в стриминг событий, вы можете без труда получать события в реальном времени из MSK Kafka и обрабатывать их перед их маршрутизацией в несколько точек назначения в Fabric. |

| MQTT (предварительная версия) | Потоки событий Microsoft Fabric позволяют подключаться к брокеру MQTT, в котором сообщения принимаются в поток событий Fabric и перенаправляются к различным назначениям внутри Fabric. |

| Solace PubSub+ (предварительная версия) | Потоки событий Microsoft Fabric позволяют подключиться к Solace PubSub+, что делает возможным получение сообщений из Solace PubSub+ в Fabric Eventstream и их маршрутизацию в различные назначения в пределах Fabric. |

Обработка событий с помощью интерфейса без кода

Сквозная схема потока данных в потоке событий позволяет получить полное представление о потоке данных и организации.

Редактор обработчика событий — это опыт перетаскивания элементов. Это интуитивно понятный способ создания обработки, преобразования и маршрутизации событий без написания кода.

| Преобразование | Описание |

|---|---|

| Фильтр | Используйте это преобразование для фильтрации событий на основе значения поля во входных данных. В зависимости от типа данных (число или текст), преобразование сохраняет значения, соответствующие выбранному условию, например is null или is not null. |

| Управление полями | Используйте это преобразование для добавления, удаления, изменения (типа данных) или переименования полей, поступающих из входного или другого преобразования. |

| Общая | Используйте это преобразование для вычисления агрегирования (суммы, минимального, максимального или среднего) при каждом возникновении нового события за период времени. Эта операция также позволяет переименовать эти вычисляемые столбцы, включая фильтрацию или срез агрегирования на основе других измерений в ваших данных. В одном преобразовании можно использовать одно или несколько агрегирований. |

| Группировать по | Используйте это преобразование для вычисления агрегатов во всех событиях в течение определенного периода времени. Вы можете выполнять группирование по значениям в одном или нескольких полях. Это как преобразование "Агрегат " в том, что оно позволяет переименовать столбцы, но предоставляет дополнительные возможности агрегирования и включает более сложные параметры для временных окон. Как и Aggregate, вы можете добавить более одной агрегации для каждого преобразования. |

| Union | Используйте это преобразование для подключения двух или нескольких узлов и добавления событий с общими полями (с одинаковым именем и типом данных) в одну таблицу. Поля, которые не соответствуют, удаляются и не включаются в выходные данные. |

| Расширять | Используйте это преобразование для создания новой строки для каждого значения в массиве. |

| Присоединиться | Используйте это преобразование для объединения данных из двух потоков на основе соответствующего условия между ними. |

Если вы включили расширенные возможности при создании потока событий, операции преобразования поддерживаются для всех назначений. Производный поток служит промежуточным звеном для некоторых мест назначения, таких как пользовательская конечная точка и активатор Fabric. Если вы не включите расширенные возможности, операции преобразования доступны только для назначений lakehouse и eventhouse (обработка событий перед приемом).

Маршрутизация событий в места назначения

Функция потоков событий Fabric поддерживает отправку данных в следующие поддерживаемые назначения.

| Назначение | Описание |

|---|---|

| Пользовательская конечная точка (пользовательское приложение в стандартных функциях) | Используйте этот пункт назначения для направления событий в режиме реального времени на пользовательскую конечную точку. Вы можете подключить собственные приложения к потоку событий и использовать данные событий в режиме реального времени. Это назначение полезно, если вы хотите отправлять данные в режиме реального времени в систему за пределами Microsoft Fabric. |

| Eventhouse | Это назначение позволяет получать данные событий в реальном времени в хранилище событий, где можно использовать мощный язык запросов Kusto (KQL) для запроса и анализа данных. С помощью данных в хранилище событий вы можете получить более подробную информацию о данных о событиях и создать богатые отчеты и панели мониторинга. Вы можете выбрать между двумя режимами приема: прямой прием и обработка событий перед приемом. |

| Озёрный Дом | Это место назначения предоставляет вам возможность преобразовывать ваши события в режиме реального времени, прежде чем принимать их в озеро данных. События в режиме реального времени преобразуются в формат Delta Lake, а затем хранятся в указанных таблицах lakehouse. Этот объект поддерживает сценарии хранения данных. |

| Производный поток | Этот специализированный тип назначения можно создать после добавления операций потока, таких как фильтр или управление полями, в поток событий. Производный поток представляет преобразованный поток по умолчанию после обработки потока. Вы можете перенаправить производный поток в несколько назначений в Fabric и просмотреть производный поток в концентраторе реального времени. |

| Активатор Fabric (предварительная версия) | Вы можете использовать это место назначения для прямого подключения данных событий в реальном времени к Fabric Activator. Активатор — это тип интеллектуального агента, который содержит всю информацию, необходимую для подключения к данным, мониторинга условий и действий. Когда данные достигают определенных пороговых значений или совпадают с другими шаблонами, активатор автоматически принимает соответствующее действие, например оповещение пользователей или запуск рабочих процессов Power Automate. |

Вы можете подключить несколько пунктов назначения к потокам событий, чтобы одновременно получать данные из потоков событий, не мешая друг другу.

Примечание.

Рекомендуется использовать функцию потоков событий Fabric по крайней мере с четырьмя единицами емкости (SKU: F4).

Apache Kafka в потоках событий Fabric

Функция потоков событий Fabric предлагает конечную точку Apache Kafka, чтобы подключить и использовать потоковые события через протокол Kafka. Если приложение уже использует протокол Apache Kafka для отправки или получения потоковых событий с определенными разделами, его можно легко подключить к потоку событий. Просто обновите параметры подключения, чтобы использовать конечную точку Kafka, указанную в потоке событий.

Функция потоков событий Fabric связана с Центрами событий Azure, полностью управляемой облачной службой. При создании потока событий пространство имен для концентратора событий создается автоматически. Концентратор событий назначается стандартному потоку без необходимости в каких-либо параметрах предоставления. Дополнительные сведения о функциях, совместимых с Kafka в Центрах событий Azure, см. в статье "Что такое Центры событий Azure для Apache Kafka?".

Дополнительные сведения о том, как получить сведения о конечной точке Kafka для отправки событий в поток событий, см. в статье "Добавление пользовательской конечной точки или пользовательского источника приложения в поток событий". Сведения об использовании событий из потока событий см. в разделе "Добавление настраиваемой конечной точки или назначения пользовательского приложения" в поток событий.

Ограничения

Потоки событий Fabric имеют следующие общие ограничения. Прежде чем работать с потоками событий, ознакомьтесь с этими ограничениями, чтобы убедиться, что они соответствуют вашим требованиям.

| Лимит | Ценность |

|---|---|

| Максимальный размер сообщения | 1 МБ |

| Максимальный срок хранения данных о событиях | 90 дней |

| Гарантии надёжности доставки событий | По крайней мере один раз |