Оценка приложений генеративного ИИ

Внимание

Элементы, обозначенные в этой статье как (предварительная версия), сейчас предлагаются в общедоступной предварительной версии. Эта предварительная версия предоставляется без соглашения об уровне обслуживания, и мы не рекомендуем ее для рабочих нагрузок. Некоторые функции могут не поддерживаться или их возможности могут быть ограничены. Дополнительные сведения см. в статье Дополнительные условия использования Предварительных версий Microsoft Azure.

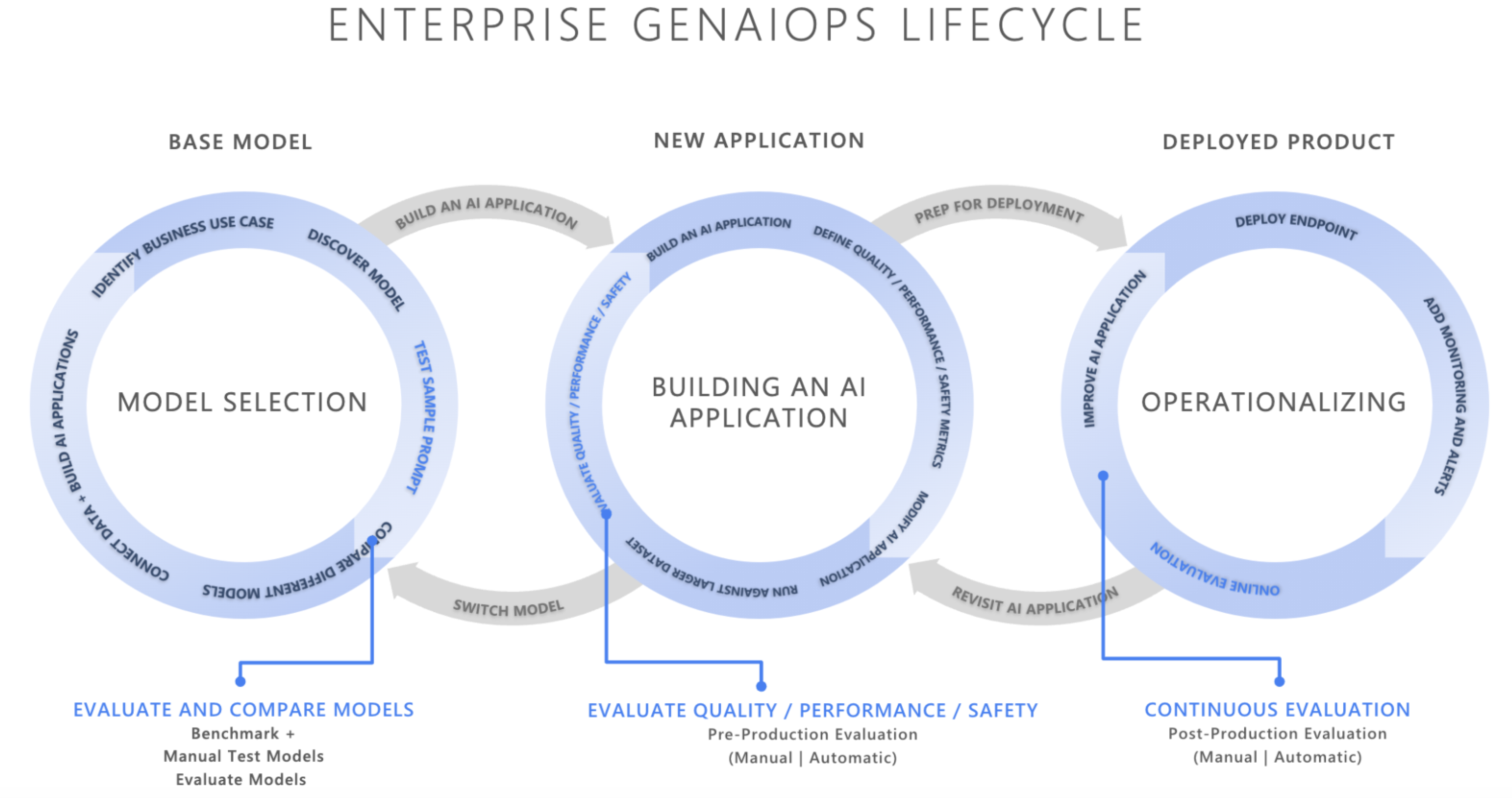

В быстро развивающемся ландшафте искусственного интеллекта интеграция операций генерирования ИИ (GenAIOps) преобразует способ разработки и развертывания приложений ИИ организациями. Поскольку предприятия все чаще полагаются на ИИ для улучшения принятия решений, улучшения взаимодействия с клиентами и внедрения инноваций, важность надежной платформы оценки не может быть чрезмерной. Оценка является важным компонентом жизненного цикла создания искусственного интеллекта для создания доверия и доверия к приложениям, ориентированным на ИИ. Если эти приложения не разработаны тщательно, эти приложения могут производить выходные данные, которые создаются и нераскрыты в контексте, неуместны или несогласованны, что приводит к плохому опыту клиентов или хуже, увековечивает социальные стереотипы, способствует неверной информации, предоставляет организациям вредоносные атаки или широкий спектр других негативных последствий.

Вычислители — это полезные средства для оценки частоты и серьезности рисков содержимого или нежелательного поведения в ответах искусственного интеллекта. Выполнение итеративных, систематических вычислений с правильными вычислителями может помочь командам измерять и устранять потенциальные проблемы с качеством реагирования, безопасностью или безопасностью на протяжении жизненного цикла разработки ИИ, начиная с начального выбора модели через постпроизводственный мониторинг. Оценка в рабочей среде жизненного цикла ops GenAI.

Понимая и реализуя эффективные стратегии оценки на каждом этапе, организации могут гарантировать, что их решения искусственного интеллекта не только соответствуют первоначальным ожиданиям, но и адаптируются и процветают в реальных средах. Давайте рассмотрим, как оценка соответствует трем критически важным этапам жизненного цикла ИИ.

Выбор базовой модели

Первый этап жизненного цикла ИИ включает выбор соответствующей базовой модели. Модели генерного искусственного интеллекта широко зависят от возможностей, сильных сторон и ограничений, поэтому важно определить, какая модель лучше подходит для конкретного варианта использования. Во время оценки базовой модели вы можете сравнить различные модели, проверив их выходные данные в отношении набора критериев, относящихся к вашему приложению.

Основные аспекты на этом этапе могут включать:

- Точность и качество: насколько хорошо модель создает соответствующие и последовательные ответы?

- Производительность конкретных задач: может ли модель обрабатывать тип запросов и содержимого, необходимых для вашего варианта использования? Как это задержка и стоимость?

- Предвзятые и этические соображения: создает ли модель какие-либо выходные данные, которые могут увековечить или способствовать вредным стереотипам?

- Риск и безопасность: существуют ли какие-либо риски для модели, создающей небезопасное или вредоносное содержимое?

Вы можете изучить тестыAzure AI Foundry для оценки и сравнения моделей на общедоступных наборах данных, а также повторного создания результатов теста на основе собственных данных. Кроме того, можно оценить одну из многих базовых моделей создания ИИ с помощью пакета SDK для оценки ИИ Azure, как показано ниже, см . пример конечных точек модели оценки.

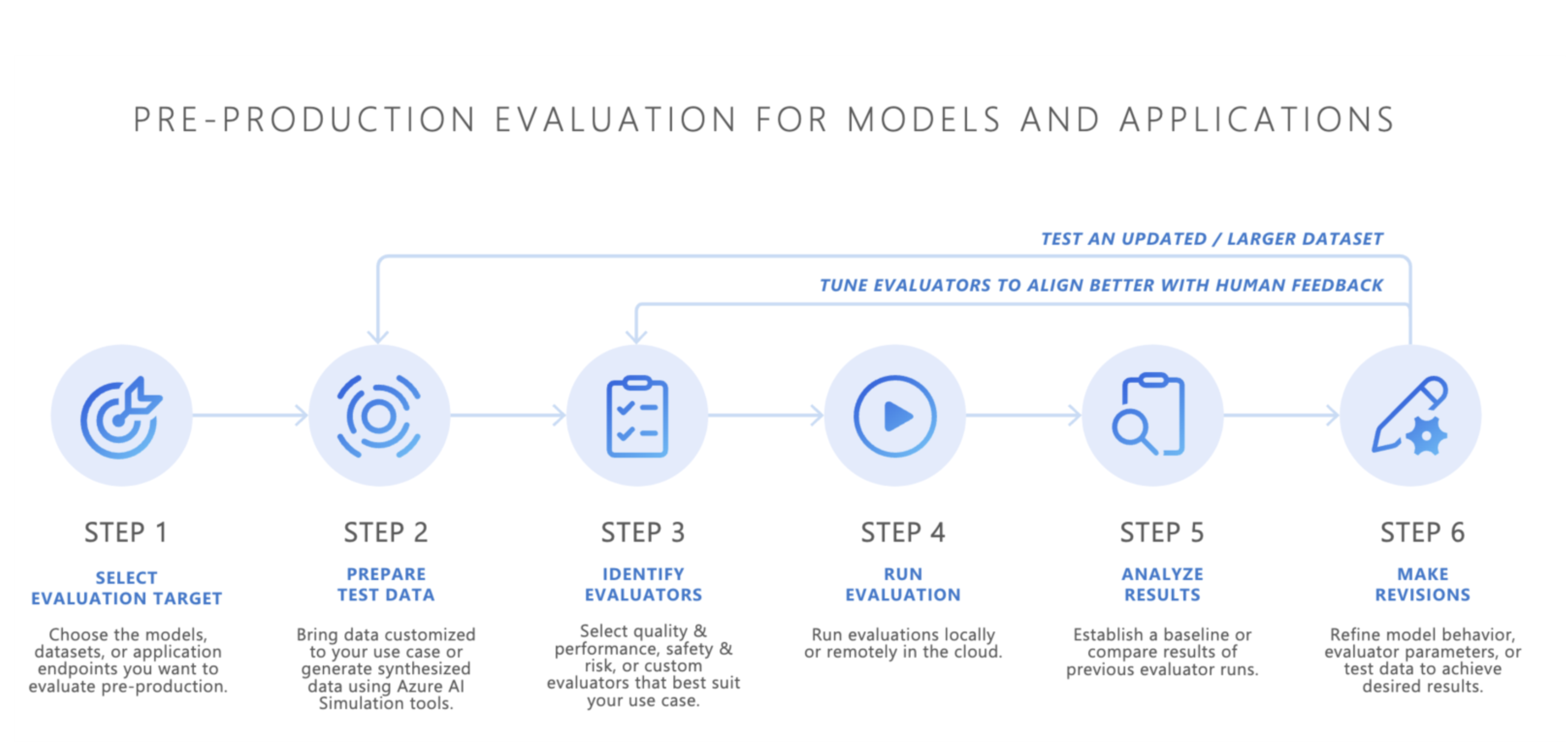

Предварительная оценка

После выбора базовой модели следующим шагом является разработка приложения ИИ, например чат-бота с использованием ИИ, приложения для получения дополненного поколения (RAG), приложения агента ИИ или любого другого средства создания ИИ. После разработки начинается предварительная оценка. Прежде чем развертывать приложение в рабочей среде, необходимо тщательное тестирование, чтобы убедиться, что модель действительно готова к реальному использованию.

Предварительная оценка включает в себя:

- Тестирование с помощью наборов данных оценки. Эти наборы данных имитируют реалистичные взаимодействия пользователей, чтобы обеспечить выполнение приложения ИИ должным образом.

- Определение пограничных вариантов: поиск сценариев, в которых качество отклика приложения ИИ может снизить или вызвать нежелательные выходные данные.

- Оценка надежности: обеспечение того, что модель может обрабатывать диапазон входных вариантов без значительного снижения качества или безопасности.

- Измерение ключевых метрик: такие метрики, как заземленность ответа, релевантность и безопасность, оцениваются для подтверждения готовности к рабочей среде.

Предварительный этап выступает в качестве окончательной проверки качества, уменьшая риск развертывания приложения ИИ, которое не соответствует требуемым стандартам производительности или безопасности.

- Принесите собственные данные. Вы можете оценить приложения ИИ в предварительной среде с помощью собственных данных оценки с помощью поддерживаемых оценщиков Azure AI Foundry или пакета SDK для оценки ИИ Azure, включая качество создания, безопасность или настраиваемые вычислители, а также просмотреть результаты с помощью портала Azure AI Foundry.

- Симуляторы: если у вас нет данных оценки (тестовые данные), симуляторы пакета SDK для оценки ИИ Azure могут помочь, создав связанные с разделом или состязательные запросы. Эти симуляторы проверяют реакцию модели на запросы, соответствующие ситуации или атаки (пограничные варианты).

- Состязательный симулятор внедряет запросы, которые имитируют потенциальные угрозы безопасности или пытаются взломать тюрьму, помогая выявлять ограничения и подготавливать модель к непредвиденным условиям.

- Контекстно-подходящие симуляторы создают типичные, соответствующие беседы , которые пользователи ожидают от пользователей, чтобы проверить качество ответов.

Кроме того, вы можете использовать мини-приложение оценки Azure AI Foundry для тестирования созданных приложений ИИ.

После достижения удовлетворительных результатов приложение ИИ можно развернуть в рабочей среде.

Мониторинг после производства

После развертывания приложение ИИ переходит на этап после рабочей оценки, также известный как онлайн-оценка или мониторинг. На этом этапе модель внедрена в реальный продукт и отвечает на фактические запросы пользователей. Мониторинг гарантирует, что модель продолжает вести себя должным образом и адаптироваться к любым изменениям в поведении пользователя или содержимом.

- Непрерывное отслеживание производительности: регулярно измеряйте ответ приложения ИИ с помощью ключевых метрик, чтобы обеспечить согласованное качество выходных данных.

- Реагирование на инциденты: быстро реагировать на любые вредные, несправедливые или неуместные выходные данные, которые могут возникнуть во время реального использования.

Постоянно отслеживая поведение приложения ИИ в рабочей среде, вы можете поддерживать высококачественные пользовательские возможности и быстро устранять все проблемы, которые возникают.

Заключение

GenAIOps — это создание надежного и повторяемого процесса для управления созданными приложениями ИИ в течение всего жизненного цикла. Оценка играет важную роль на каждом этапе, от выбора базовой модели до предварительного тестирования до текущего мониторинга после производства. Систематически измеряя и устраняя риски и уточняя системы ИИ на каждом шаге, команды могут создавать генеривные решения ИИ, которые не только мощные, но и надежные и безопасные для реального использования.

Краткий справочник.

| Характер использования | Обработка | Параметры |

|---|---|---|

| Что вы оцениваете? | Определение или сборка соответствующих вычислителей | - Качество и производительность (записная книжка "Качество и производительность") - Безопасность и безопасность (пример записной книжки безопасности и безопасности) - Custom (Custom sample notebook) |

| Какие данные следует использовать? | Отправка или создание соответствующего набора данных | Универсальный симулятор для измерения качества и производительности (пример записной книжки универсального симулятора) - Состязательный симулятор для измерения безопасности и безопасности (пример записной книжки для состязательного симулятора) |

| Какие ресурсы должны проводить оценку? | Запуск оценки | — локальный запуск — удаленное выполнение облака |

| Как выполнялась модель или приложение? | Анализ результатов | Просмотр статистических показателей, просмотр сведений, сведений о оценке, сравнение запусков оценки |

| Как улучшить? | Внесение изменений в модель, приложение или вычислители | — Если результаты оценки не соответствуют человеческим отзывам, настройте оценщика. — Если результаты оценки соответствуют человеческим отзывам, но не соответствуют пороговым значениям качества и безопасности, применяются целевые меры по устранению рисков. |