Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Это важно

Элементы, обозначенные в этой статье как (предварительная версия), сейчас предлагаются в общедоступной предварительной версии. Эта предварительная версия предоставляется без соглашения об уровне обслуживания, и мы не рекомендуем ее для рабочих нагрузок. Некоторые функции могут не поддерживаться или их возможности могут быть ограничены. Для получения дополнительной информации см. Дополнительные условия использования для предварительных версий Microsoft Azure.

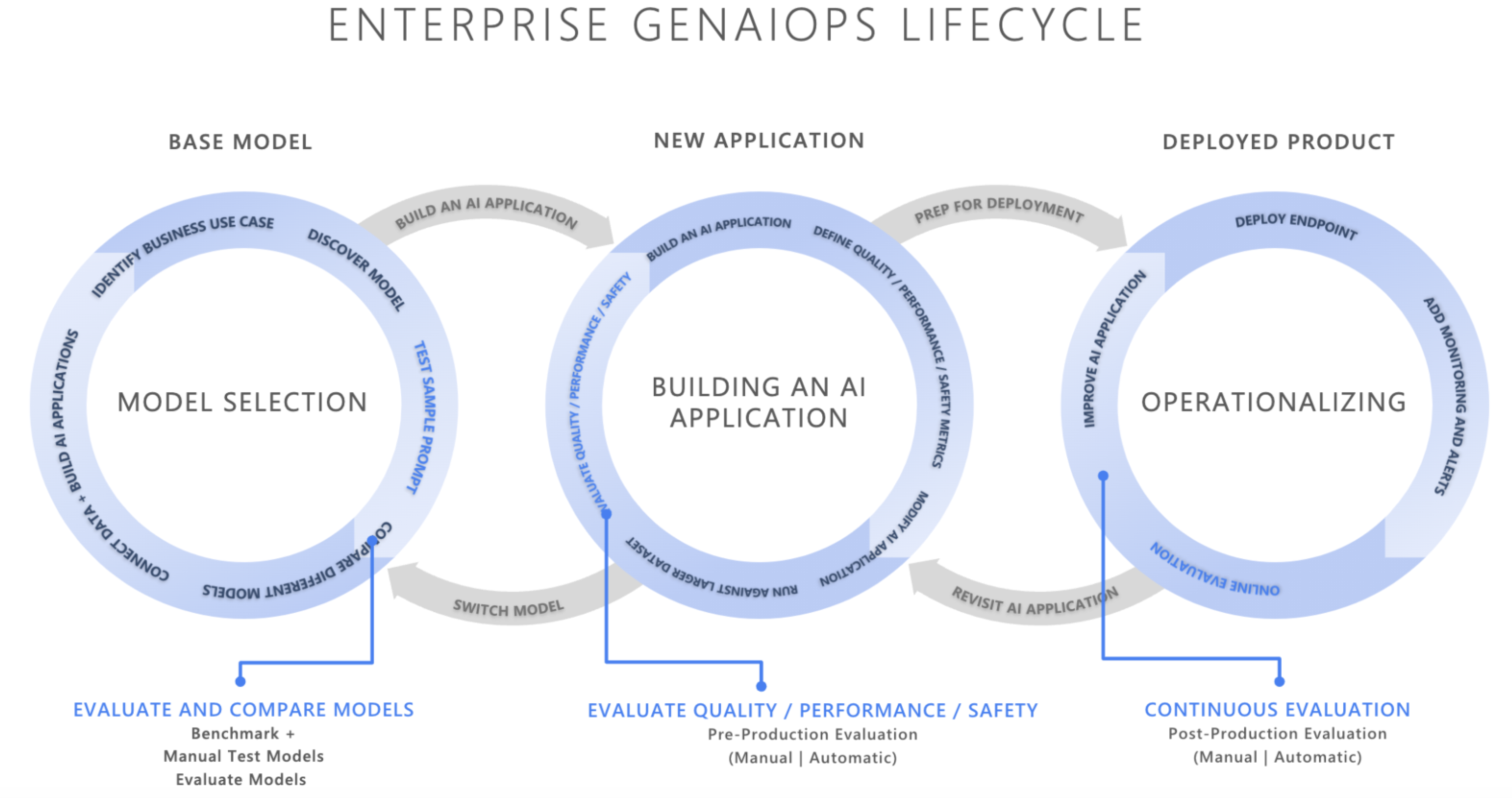

В современном мире, ориентированном на искусственный интеллект, создание операций искусственного интеллекта (GenAIOps) является революцией в том, как организации создают и развертывают интеллектуальные системы. По мере того как компании все чаще используют ИИ для преобразования принятия решений, улучшения взаимодействия с клиентами и повышения эффективности инноваций, один элемент имеет первостепенное значение: надежные платформы оценки. Оценка — это не только контрольная точка. Это основа доверия к приложениям искусственного интеллекта. Без строгой оценки системы ИИ могут создавать контент, который:

- Сфабриковано или не имеет отношения к реальности

- Неуместное или несогласованное с потребностями пользователя

- Вредно в увековечении рисков и стереотипов содержания

- Опасно распространять дезинформацию

- Уязвимые для эксплойтов безопасности

Вот где эксперты становятся незаменимыми. Эти специализированные средства измеряют частоту и серьезность рисков в выходных данных ИИ, что позволяет командам систематически решать проблемы качества, безопасности и безопасности на протяжении всего процесса разработки ИИ— от выбора подходящей модели для мониторинга производительности, качества и безопасности.

Что такое оценщики?

Оценщики — это специализированные инструменты, которые измеряют качество, безопасность и надежность ответов ИИ. Реализуя систематические оценки в течение жизненного цикла разработки ИИ, команды могут выявлять и устранять потенциальные проблемы, прежде чем они влияют на пользователей. Следующие поддерживаемые вычислители предоставляют комплексные возможности оценки для различных типов приложений ИИ и проблем.

RAG (поиск с дополненной генерацией):

| Оценщик | Цель |

|---|---|

| Возвращение | Измеряет, насколько эффективно система получает соответствующую информацию. |

| Извлечение документов | Измеряет точность в результатах извлечения, учитывая эталонные данные. |

| Обоснованность | Измеряет согласованность ответа относительно полученного контекста. |

| Устойчивость Pro | Измеряет, согласуется ли ответ с учетом полученного контекста. |

| Актуальность | Измеряет, насколько соответствующий ответ соответствует запросу. |

| Полнота ответа | Меры в той степени, в какой ответ завершен (не отсутствует критическая информация) по отношению к эталонным данным. |

Агенты (предварительная версия):

| Оценщик | Цель |

|---|---|

| Определение намерений | Измеряет, насколько точно агент определяет и решает намерения пользователей. |

| Соблюдение задач | Измеряет, насколько хорошо агент следует за идентифицированными задачами. |

| Точность вызова инструмента | Измеряет, насколько эффективно агент выбирает и вызывает правильные инструменты. |

| Оценщик | Цель |

|---|---|

| Беглость | Измеряет качество естественного языка и удобочитаемость. |

| Согласованность | Измеряет логическую согласованность и поток ответов. |

| Обеспечение качества | Измеряет различные аспекты качества в процессе ответов на вопросы комплексно. |

Безопасность и безопасность (предварительная версия):

| Оценщик | Цель |

|---|---|

| Насилие | Обнаруживает насильственное содержимое или подстрекательство. |

| Половой | Определяет неуместное сексуальное содержимое. |

| Самоповредение | Обнаруживает содержимое, повышающее или описывающее самоповредение. |

| Ненависть и несправедливость | Определяет предвзятое, дискриминационное или ненавистное содержимое. |

| Необоснованные атрибуты | Обнаруживает вымышленные или галлюцинированные сведения, полученные из взаимодействия с пользователем. |

| Уязвимость кода | Определяет проблемы безопасности в созданном коде. |

| Защищенные материалы | Обнаруживает несанкционированное использование содержимого, защищенного авторским правом или иным образом защищенного. |

| Безопасность содержимого | Комплексная оценка различных проблем безопасности. |

| Оценщик | Цель |

|---|---|

| Сходство | Измерение текстового сходства с помощью искусственного интеллекта. |

| F1-мера | Гармоничный средний коэффициент точности и отзыва в токене перекрывается между ответом и земной правдой. |

| BLEU | Двуязычная оценка BLEU для измерения качества перевода оценивает совпадения n-грамм между ответом и эталонным текстом. |

| GLEU | Google-BLEU вариант для оценки на уровне предложения определяет совпадения в n-граммах между ответом и эталонными данными. |

| РУМЯНА | Recall-Oriented Замена для оценки Gisting измеряет перекрытия в n-граммах между ответом и эталонными данными. |

| МЕТЕОР | Метрика для оценки перевода с явным упорядочением измеряет пересечение n-грамм между ответом и истинными данными. |

Azure OpenAI Graders (предварительная версия):

| Оценщик | Цель |

|---|---|

| Метчик моделей | Классифицирует содержимое с помощью пользовательских рекомендаций и меток. |

| Средство оценки модели | Создает числовые оценки (настраиваемый диапазон) для содержимого на основе пользовательских рекомендаций. |

| Средство проверки строки | Выполняет гибкие проверки текста и сопоставление шаблонов. |

| Подобие текста | Оценивает качество текста или определяет семантическую близость. |

Используя эти вычислители стратегически на протяжении всего жизненного цикла разработки, команды могут создавать более надежные, безопасные и эффективные приложения ИИ, которые соответствуют потребностям пользователей, минимизируя потенциальные риски.

Три этапа оценки GenAIOps

Выбор базовой модели

Прежде чем создавать приложение, необходимо выбрать правильный фундамент. Эта начальная оценка помогает сравнить различные модели на основе:

- Качество и точность: насколько релевантны и последовательны ответы модели?

- Производительность задачи: эффективно ли модель обрабатывает конкретные варианты использования?

- Этические соображения: модель свободна от вредных предвзятости?

- Профиль безопасности: что такое риск создания небезопасного содержимого?

Доступные средства: тест azure AI Foundry для сравнения моделей с общедоступными наборами данных или собственными данными, а также пакет SDK для оценки ИИ Azure для тестирования определенных конечных точек модели.

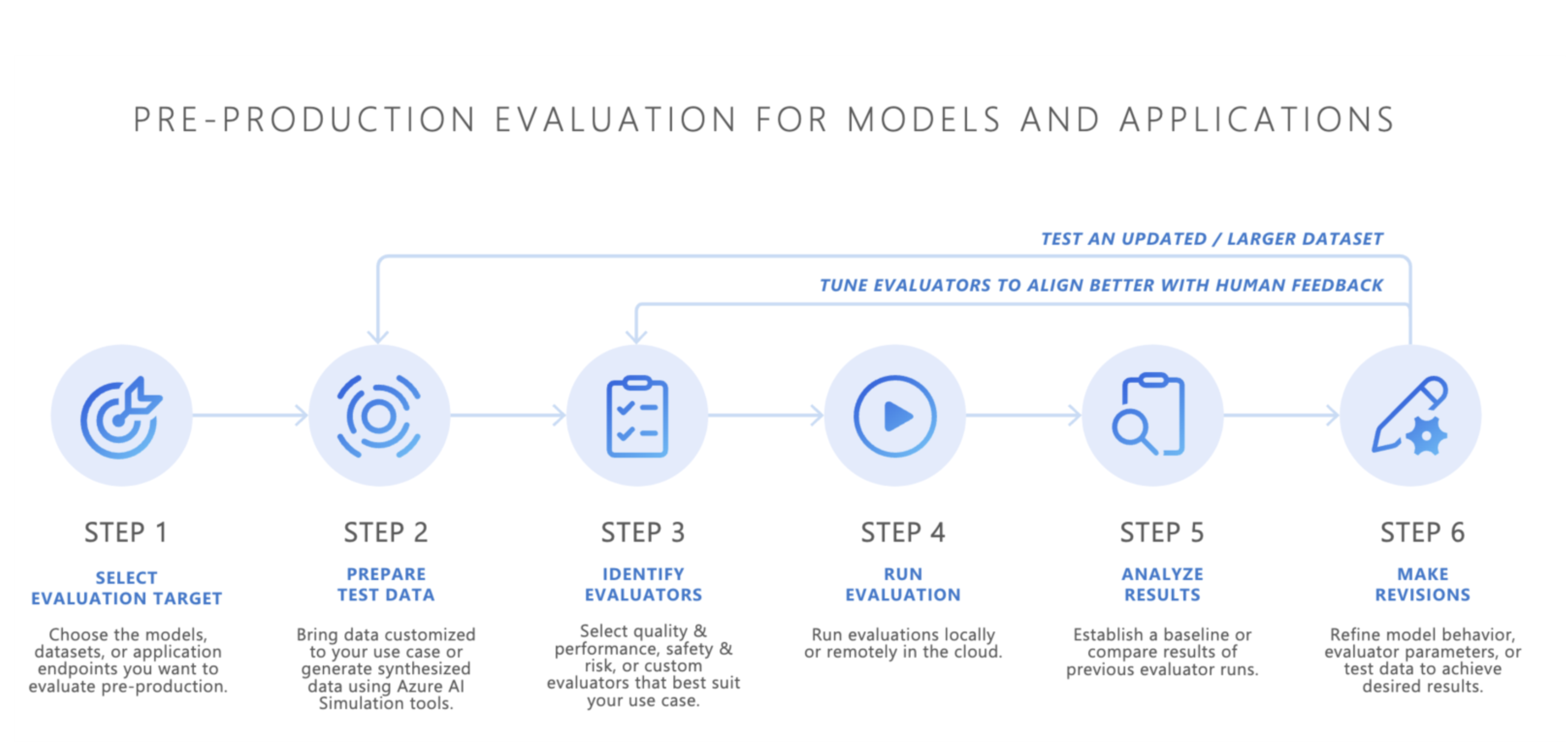

Оценка перед производством

После выбора базовой модели следующим шагом является разработка приложения ИИ, например ИИ чат-бота, приложения с генерацией дополненного поиска (RAG), агентного приложения ИИ или любого другого инструмента генерации искусственного интеллекта. После завершения разработки начинается предварительная оценка. Перед развертыванием в рабочей среде необходимо тщательное тестирование, чтобы убедиться, что модель готова к реальному использованию.

Предварительная оценка включает в себя:

- Тестирование с помощью наборов данных оценки. Эти наборы данных имитируют реалистичные взаимодействия пользователей, чтобы обеспечить выполнение приложения ИИ должным образом.

- Определение пограничных вариантов: поиск сценариев, в которых качество отклика приложения ИИ может снизить или вызвать нежелательные выходные данные.

- Оценка надежности: обеспечение того, что модель может обрабатывать диапазон входных вариантов без значительного снижения качества или безопасности.

- Измерение ключевых метрик: такие метрики, как обоснованность ответа, релевантность и безопасность, оцениваются для подтверждения готовности к производственной среде.

Предварительный этап выступает в качестве окончательной проверки качества, уменьшая риск развертывания приложения ИИ, которое не соответствует требуемым стандартам производительности или безопасности.

Средства оценки и подходы:

- Выберите собственные данные: вы можете оценить приложения ИИ в тестовой среде, используя свои собственные данные оценки с поддерживаемыми оценщиками, включая качество генерации, безопасность или настраиваемые категории, и просматривать результаты через портал Azure AI Foundry. Используйте мастер оценивания Azure AI Foundry или поддерживаемые оценщики пакета SDK для оценки AI Azure, включая качество генерации, безопасность или настраиваемые оценщики, и просматривайте результаты через портал Azure AI Foundry.

- Симуляторы и агент командной группы ИИ (предварительная версия): если у вас нет данных оценки (тестовые данные), симуляторы пакета SDK для оценки ИИ Azure могут помочь, создав связанные с темами или состязательные запросы. Эти симуляторы проверяют реакцию модели на запросы, соответствующие ситуации или напоминающие атаку (граничные случаи).

- Состязательные симуляторы внедряют статические запросы, которые имитируют потенциальные риски безопасности или атаки безопасности, такие как или попытки взлома, помогая определить ограничения и подготовить модель к непредвиденным условиям.

- Контекстуально соответствующие симуляторы создают типичные беседы, которых ожидают пользователи, чтобы проверить качество ответов. С помощью контекстных симуляторов можно оценить такие метрики, как заземление, релевантность, согласованность и беглость созданных ответов.

- Агент красной команды искусственного интеллекта (предварительная версия) имитирует сложные противоположные атаки на систему ИИ, используя широкий спектр атак безопасности и защиты с помощью открытой платформы инструмента идентификации рисков на Python от Майкрософт или PyRIT. Автоматические проверки с помощью агента командной группы искусственного интеллекта повышают предварительную оценку рисков путем систематического тестирования приложений ИИ для рисков. Этот процесс включает имитированные сценарии атаки для выявления слабых мест в ответах модели до реального развертывания. Проводя проверки на прочность с использованием ИИ, вы можете обнаруживать и устранять потенциальные проблемы безопасности перед развертыванием. Это средство рекомендуется использовать в процессах взаимодействия с человеком, таких как стандартное тестирование уязвимостей в искусственном интеллекте для ускорения выявления рисков и содействия в оценке, проводимой экспертом.

Кроме того, вы можете использовать мини-приложение оценки портала Azure AI Foundry для тестирования созданных приложений ИИ.

После достижения удовлетворительных результатов приложение ИИ можно развернуть в рабочей среде.

Мониторинг после производства

После развертывания непрерывное наблюдение гарантирует, что ваше приложение ИИ поддерживает качество в реальных условиях:

- Отслеживание производительности: регулярное измерение ключевых метрик.

- Реагирование на инциденты: быстрые действия при возникновении вредных или неуместных выходных данных.

Эффективный мониторинг помогает поддерживать доверие пользователей и позволяет быстро устранить проблемы.

Наблюдаемость Azure AI Foundry предоставляет комплексные возможности мониторинга, необходимые для современного сложного и быстро изменяющегося ландшафта ИИ. Это решение обеспечивает непрерывный мониторинг развернутых приложений ИИ для обеспечения оптимальной производительности, безопасности и качества в рабочих средах. Панель мониторинга "наблюдаемость" предоставляет данные о критически важных метриках в режиме реального времени, позволяя командам быстро выявлять и устранять проблемы с производительностью, безопасности или снижением качества. Для приложений на основе агента Foundry предлагает расширенные возможности непрерывной оценки, которые можно включить для обеспечения более глубокой видимости метрик качества и безопасности, создавая надежную экосистему мониторинга, которая адаптируется к динамическому характеру приложений ИИ при сохранении высоких стандартов производительности и надежности.

Постоянно отслеживая поведение приложения ИИ в рабочей среде, вы можете поддерживать высококачественные пользовательские возможности и быстро устранять все проблемы, которые возникают.

Создание доверия с помощью систематической оценки

GenAIOps устанавливает надежный процесс управления приложениями ИИ на протяжении всего жизненного цикла. Реализуя тщательную оценку на каждом этапе от выбора модели до развертывания и за ее пределами, команды могут создавать решения искусственного интеллекта, которые не только мощные, но надежные и безопасные.

Памятка по оценке

| Цель | Процедура | Параметры |

|---|---|---|

| Для чего вы оцениваете? | Определение или создание соответствующих оценщиков |

-

Образец записной книжки для оценки качества и производительности - Качество отклика агентов - Безопасность и охрана (Пример записной книжки по безопасности и охране) - Пользовательский (Пользовательский пример записной книжки) |

| Какие данные следует использовать? | Отправка или создание соответствующего набора данных |

Универсальный симулятор для измерения качества и производительности (пример записной книжки для универсального симулятора) - Симулятор оппонента для измерения безопасности и защищенности (пример ноутбука для симулятора оппонента) Агент командной группы искусственного интеллекта для выполнения автоматизированных проверок для оценки уязвимостей безопасности и безопасности (пример записной книжки агента red teaming СИ) |

| Какие ресурсы должны проводить оценку? | Запуск оценки |

-

Локальный запуск - Удаленный запуск в облаке |

| Как выполнялась модель или приложение? | Анализ результатов | Просмотр статистических показателей, просмотр деталей, просмотр деталей оценки, сравнение запусков оценивания |

| Как улучшить? | Внесите изменения в модель, приложение или оценщиков | — Если результаты оценки не соответствуют человеческим отзывам, настройте оценщика. — Если результаты оценки соответствуют человеческим отзывам, но не соответствуют пороговым значениям качества и безопасности, применяются целевые меры по устранению рисков. Пример мер по снижению рисков: Azure AI Content Safety |

Поддержка регионов

В настоящее время некоторые оценочные системы с поддержкой ИИ доступны только в следующих регионах:

| Регион | Ненависть и несправедливость, сексуальные материалы, насильственные, самоповреждения, непрямая атака, уязвимости кода, необоснованные атрибуты | Устойчивость Pro | Защищаемый материал |

|---|---|---|---|

| Восток США 2 | Поддерживается | Поддерживается | Поддерживается |

| Центральная Швеция | Поддерживается | Поддерживается | Не применимо |

| Северо-Центральный район США | Поддерживается | Не применимо | Не применимо |

| Центральная Франция | Поддерживается | Не применимо | Не применимо |

| Западная Швейцария | Поддерживается | Не применимо | Не применимо |

Ценообразование

Функции наблюдения, такие как оценки рисков и безопасности и непрерывные оценки, выставляются на основе потребления, как указано на странице цен Azure. Выберите вкладку с меткой Complete AI Toolchain , чтобы просмотреть сведения о ценах для оценки.