Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Правила и стандарты ИИ появляются в разных регионах и отраслях, предоставляя надежную платформу для организаций для оценки, реализации и тестирования их элементов управления для разработки и использования надежного ИИ. Эта статья помогает группам риска и соответствия требованиям подготовиться к усилиям по соответствию требованиям. В нем описывается, как:

- Оцените и укрепите состояние соответствия нормативным требованиям.

- Реализуйте элементы управления для управления использованием приложений ИИ и данных.

Это четвертая статья серии. Если вы еще не выполнили задачи в разделе "Подготовка к безопасностиИИ", обнаружение приложений и данных ИИ, а также защита приложений и данных ИИ, начните с этих статей, чтобы подготовить среду с возможностями, указанными в этой статье.

Используйте эту статью вместе с этими ресурсами:

- Бизнес-сценарий внедрения нулевого доверия— соответствие нормативным требованиям и требованиям соответствия с нулевым доверием

- Cloud Adoption Framework (CAF) для ИИ — процесс управления искусственным интеллектом

Каковы новые рекомендации по управлению приложениями и данными ИИ?

Так же, как ИИ вводит новые области атак, которые изменяют ландшафт риска, ИИ также вводит новые методы обработки и использования данных, влияющих на соответствие нормативным требованиям. Эти новые характеристики ИИ влияют как на существующие правила, такие как правила конфиденциальности, так и новые правила, предназначенные специально для использования ИИ.

На следующем рисунке рассматриваются новые правила искусственного интеллекта, включая закон об искусственном интеллекте и данных (AIDA) в Северной Америке, Закон о ИИ ЕС, план действий ИИ в Австралии и глобальные стандарты, созданные ISO.

В целом, управление ИИ для соответствия нормативным требованиям включает в себя:

- Ведение журнала и сохранение взаимодействий СИ.

- Обнаружение потенциального несоответствующего использования.

- При необходимости используйте такие средства, как обнаружение электронных данных при взаимодействии с искусственным интеллектом.

Это помогает организациям отвечать требованиям к соответствию требованиям и эффективно реагировать на потенциальные судебные разбирательства.

Для организаций, создающих ИИ, группы по управлению рисками и соблюдению нормативных требований должны позволить командам разработчиков документировать свои данные о проекте, такие как имя модели, версия, назначение систем ИИ и их метрики оценки для решения проблем качества, безопасности и защищенности. Эти усилия могут помочь группам по рискам и соответствию требованиям иметь стандартный формат информации для подготовки к аудиту и реагирования на нормативные запросы.

Ещё одной лучшей практикой является использование оценок влияния на конфиденциальность, меры, которую многие компании уже внедрили для соблюдения таких нормативов, как GDPR, чтобы гарантировать, что приложения с ИИ имеют все необходимые оценки и меры для защиты конфиденциальности. Корпорация Майкрософт предоставляет такие возможности, как оценки конфиденциальности Priva, которые можно легко интегрировать в жизненный цикл разработки искусственного интеллекта, чтобы разработчики держали в виду конфиденциальность.

Наконец, для создания ответственных приложений ИИ и соблюдения новых нормативных требований организации должны создавать средства защиты для обнаружения и блокирования вредного содержимого, таких как насилие, ненависть, сексуальное и самовредоносное содержимое. Кроме того, вы хотите, чтобы приложения ИИ производили надежное содержимое. Ограждения должны помочь обнаруживать и исправлять некорректную информацию, чтобы снизить риск ошибочных решений на основе необоснованных результатов. Они также должны определять содержимое, которое нарушает авторские права. Эти средства защиты помогают организациям создавать ответственные и надежные приложения искусственного интеллекта.

Возможности управления приложениями и данными ИИ

Корпорация Майкрософт включает возможности, помогающие организациям связывать точки между нормативными стандартами и технологическими решениями.

Следующие шаги описывают иллюстрацию, а также пошаговые инструкции по реализации этих возможностей.

| Этап | Задача | Область действия |

|---|---|---|

| 1 | Создание оценок и управление ими в Microsoft Purview Compliance Manager | В масштабе всего предприятия |

| 2 | Использование Defender для облачных приложений для управления приложениями ИИ на основе риска соответствия требованиям | Приложения SaaS AI |

| 3 | Используйте управление облачной безопасностью (CSPM) для рабочих нагрузок ИИ, чтобы обнаруживать и управлять пользовательскими приложениями, основанными на риске несоответствия требованиям. | Пользовательские приложения на основе индивидуально разработанного искусственного интеллекта Azure |

| 4 | Настройка соответствия коммуникациям Purview для минимизации рисков, помогая обнаруживать, фиксировать и реагировать на потенциально неуместные сообщения в вашей организации | Приложения и службы Microsoft 365 Приложения ИИ, подключенные соединителями Microsoft Entra или Microsoft Purview Data Map |

| 5 | Настройте управление жизненным циклом данных Purview, чтобы сохранять нужное содержимое и удалять то, которое не требуется. | Приложения и службы Microsoft 365 |

| 6 | Используйте возможность обнаружения электронных данных и аудит журналов Microsoft 365 Copilot для расследований в случае необходимости. | Microsoft 365 Copilot, Microsoft Copilot |

| 7 | Использование оценок конфиденциальности Priva для инициирования оценки влияния на конфиденциальность для приложений искусственного интеллекта, которые вы создаете | Любое приложение, любое расположение |

| 8 | Использование отчетов ИИ в AI Foundry для документирования сведений о проекте ИИ для разрабатываемых приложений | Приложения ИИ в Azure |

| 9 | Реализация функций безопасности содержимого AI Azure для блокировки вредного содержимого, а также обнаружения и исправления необоснованных ответов. | Приложения ИИ в Azure |

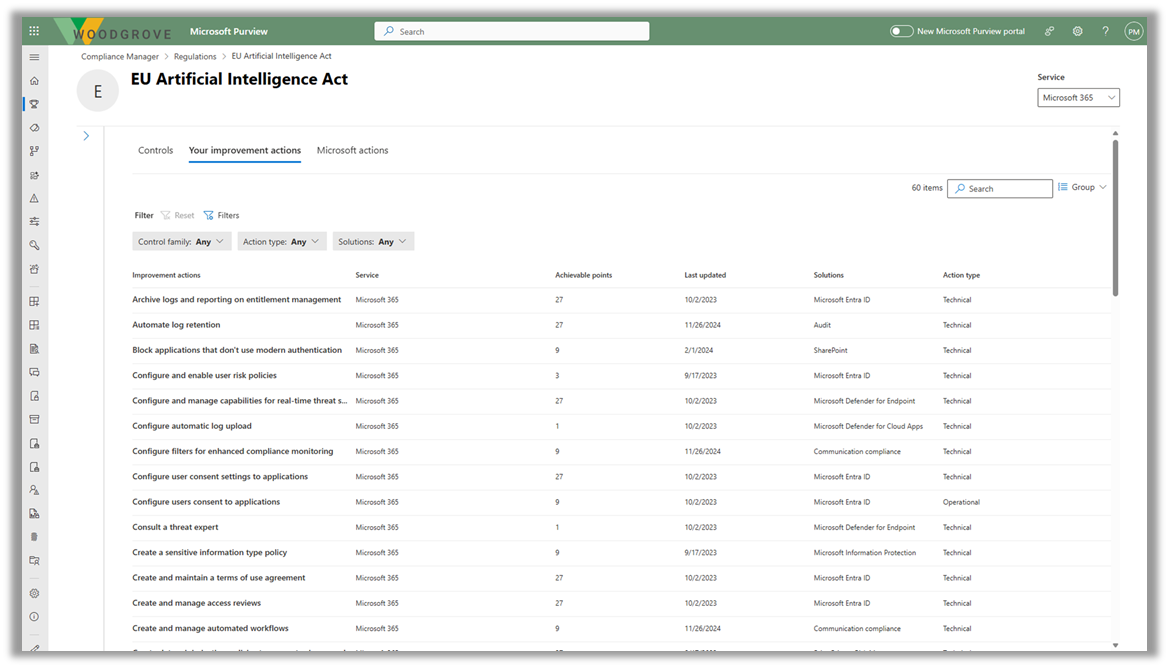

Шаг 1. Создание оценки и управление ими в Microsoft Purview Compliance Manager

Microsoft Purview Compliance Manager — это решение, которое помогает автоматически оценивать соответствие требованиям и управлять ими в многооблачной среде. Диспетчер соответствия требованиям поможет вам на протяжении всего пути к соответствию требованиям, от составления списка рисков защиты данных до управления сложными моментами реализации элементов управления, получения сведений о нормативных требованиях и сертификатах, а также отправки отчетов аудиторам.

В настоящее время диспетчер соответствия требованиям включает шаблоны нормативных требований для следующих нормативных требований, связанных с ИИ:

- Закон об искусственном интеллекте ЕС

- ISO/IEC 23894:2023

- ISO/IEC 42001:2023

- NIST AI Risk Management Framework (RMF) 1.0

Чтобы приступить к работе с диспетчером соответствия требованиям, используйте следующие ресурсы.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте и начните пользоваться |

Диспетчер соответствия требованиям Microsoft Purview Начало работы с Microsoft Purview Compliance Manager Создание оценки и управление ими в Microsoft Purview Compliance Manager |

| Узнайте, включает ли диспетчер соответствия требованиям шаблон для регулирования | Список правил |

| Создание пользовательской оценки | Создание пользовательских оценок (предварительная версия) в Microsoft Purview Compliance Manager |

Шаг 2. Использование Defender для облачных приложений

Используйте Defender для облачных приложений для управления приложениями ИИ на основе риска соответствия требованиям. В предыдущих статьях этой серии описано, как использовать Defender для облачных приложений для обнаружения, управления и защиты приложений ИИ. Соответствие нормативным требованиям вводит дополнительные критерии для рассмотрения и оценки риска этих приложений.

После создания одной или нескольких оценок для конкретных правил в Purview Compliance Manager обратитесь к команде Defender для облачных приложений, чтобы интегрировать свои обязательства по соответствию требованиям для оценки риска приложений ИИ, санкционирования или блокировки этих приложений и применения политик сеансов для управления доступом к этим приложениям (например, только с соответствующим устройством).

Ознакомьтесь с предыдущими статьями в этой серии, чтобы приступить к работе и использовать Defender для облачных приложений.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Обнаружение, санкционирование и блокировка приложений ИИ с помощью Microsoft Defender для облачных приложений | См . шаг 2 в статье "Обнаружение приложений и данных ИИ" |

| Использование Defender для облачных приложений для анализа и защиты использования приложений ИИ | Дополнительные сведения о защите от угроз для ИИ см. в статье "Защита приложений и данных ИИ" |

Шаг 3. Используйте управление параметрами безопасности облака (CSPM) для нагрузок ИИ

Используйте план управления безопасностью в Defender Cloud Security (CSPM) в Microsoft Defender для облака, чтобы обнаруживать и управлять самостоятельно созданными приложениями на основе риска несоответствия требованиям. Точно так же, как Defender для облачных приложений, соответствие нормативным требованиям предоставляет дополнительные критерии для рассмотрения и оценки риска пользовательских созданных приложений с помощью CSPM для искусственного интеллекта.

Обратитесь к команде Defender для облака, чтобы интегрировать свои обязательства по соответствию требованиям в критерии оценки риска и управления пользовательскими приложениями.

Ознакомьтесь с предыдущими статьями в этой серии, чтобы приступить к работе и использовать Defender для облака.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Обнаружение развернутых рабочих нагрузок ИИ в среде и получение аналитических сведений о безопасности с помощью Microsoft Defender для облака | См. шаг 3 в статье "Обнаружение приложений и данных ИИ" |

| Применение защиты искусственного интеллекта в Defender для облака | См. шаг 2. Получение наиболее эффективной защиты от угроз для ИИ в приложениях ИИ и данных |

Шаг 4. Настройка соответствия связи Purview

Настройте систему Purview Communication Compliance для минимизации рисков общения, помогая обнаруживать, фиксировать и реагировать на потенциально неуместные сообщения в вашей организации. Для создания искусственного интеллекта можно использовать политики соответствия связи для анализа взаимодействий (запросов и ответов), введенных в создаваемые приложения ИИ, чтобы помочь обнаружить неуместные или рискованные взаимодействия или совместное использование конфиденциальной информации. Покрытие поддерживается для Microsoft 365 Copilot, Copilots, созданных с помощью Microsoft Copilot Studio, приложений ИИ, подключенных к соединителям Microsoft Entra или Microsoft Purview Data Map, и многое другое.

Чтобы приступить к работе, используйте следующие ресурсы.

Шаг 5. Настройка управления жизненным циклом данных Purview

Управление жизненным циклом данных Microsoft Purview предоставляет инструменты и возможности для сохранения необходимого содержимого и удаления того, которое вам не нужно. Упреждающее удаление содержимого, которое больше не требуется для сохранения, помогает снизить риск превышения уровня данных в средствах искусственного интеллекта. К ключевым функциям относятся:

- Политики и метки хранения

- Архивация почтовых ящиков и неактивные почтовые ящики— почтовые ящики пользователей включают скрытую папку с запросами и ответами Copilot.

Чтобы приступить к работе, используйте следующие ресурсы.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте и начните работу |

Сведения об управлении жизненным циклом данных Microsoft Purview Начните работу с управлением жизненным циклом данных |

Шаг 6. Используйте eDiscovery вместе с журналами аудита для Microsoft 365 Copilot

Используйте Microsoft Purview eDiscovery для поиска ключевых слов в запросах и ответах Copilot, которые могут быть неуместными. Вы также можете включить эти сведения в дело обнаружения электронных данных, чтобы просмотреть, экспортировать или отложить эти данные для текущего судебного расследования.

Используйте журналы аудита Microsoft Purview, чтобы определить, как, когда и где произошло взаимодействие Copilot и какие элементы были доступны, включая все метки конфиденциальности для этих элементов.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте, где хранятся данные об использовании Copilot и как его можно проверить | Архитектура защиты данных и аудита в Microsoft 365 Copilot |

| Начало работы с eDiscovery | Сведения о решениях обнаружения электронных данных |

| Сведения о журналах аудита Purview | Сведения о решениях аудита в Microsoft Purview |

Шаг 7. Использование оценок конфиденциальности Priva

Используйте оценки конфиденциальности Priva (предварительная версия), чтобы инициировать оценки влияния конфиденциальности для приложений ИИ, которые вы создаете. Это помогает гарантировать, что приложения искусственного интеллекта создаются с учетом защиты конфиденциальности. Оценки конфиденциальности автоматизируют обнаружение, документацию и оценку использования персональных данных во всем пространстве данных.

Используйте следующие ресурсы, чтобы приступить к оценке конфиденциальности Priva и инициировать оценку влияния на конфиденциальность.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте больше и начните |

Сведения об оценках конфиденциальности Начало работы с оценками конфиденциальности |

| Создание оценки | Создание оценок конфиденциальности и управление ими |

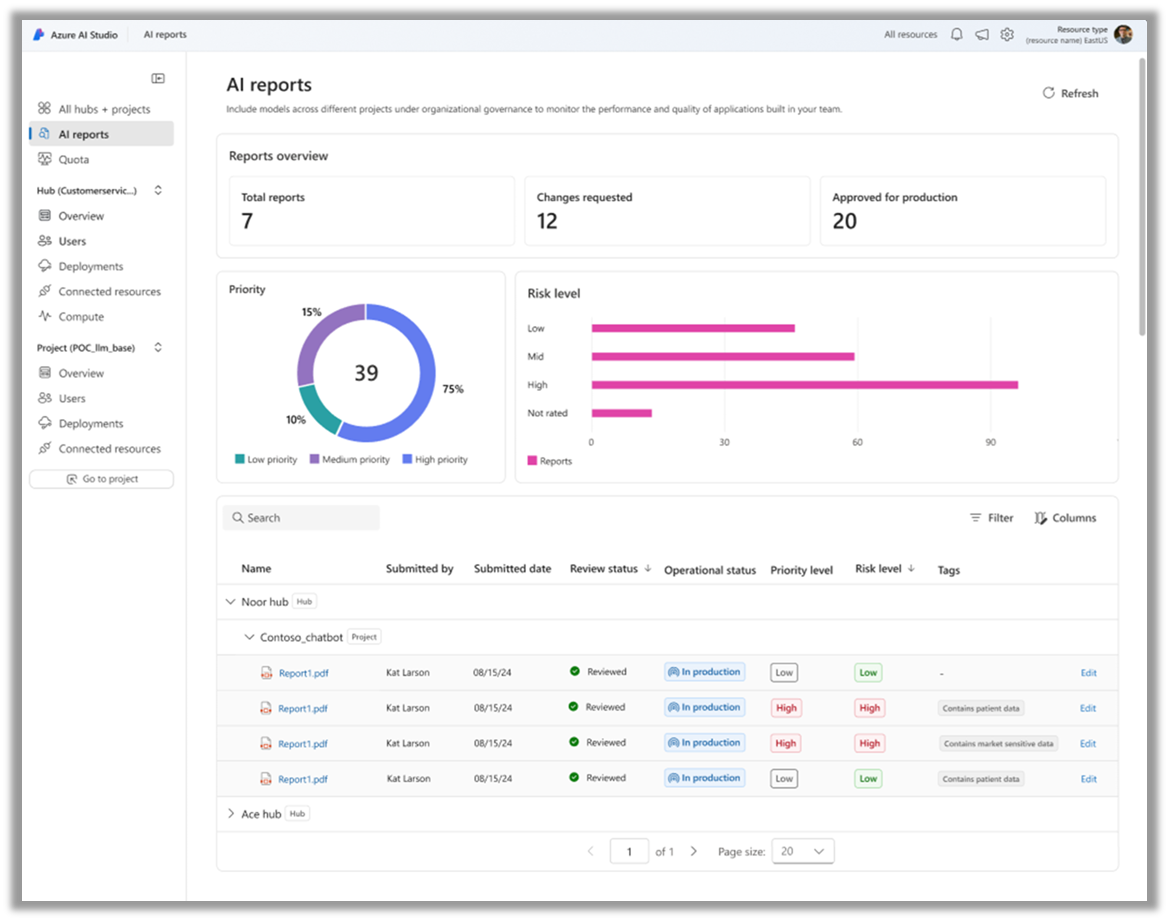

Шаг 8. Использование отчетов ИИ в AI Foundry

Отчеты ИИ в Azure AI Foundry могут помочь разработчикам документирование сведений о проекте. Разработчики могут создать отчет, показывающий все сведения о проекте ИИ, такие как карточки моделей, версии модели, конфигурации фильтра безопасности содержимого и метрики оценки. Этот отчет можно экспортировать в форматах PDF или SPDX, помогая командам разработчиков продемонстрировать готовность к работе в рабочих процессах управления, рисках и соответствии (GRC) и упростить текущие аудиты приложений в рабочей среде.

Чтобы приступить к работе, используйте следующие ресурсы.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте о отчетах ИИ в AI Foundry (блог) | Отчёты ИИ: совершенствование управления ИИ и «GenAIOps» с согласованной документацией |

| Узнайте о ИИ Foundry и начните работу с ним | Что такое Azure AI Foundry? |

Шаг 9. Реализация безопасности содержимого ИИ Azure

Безопасность содержимого ИИ Azure — это служба искусственного интеллекта, которая обнаруживает вредное содержимое, созданное пользователем и ИИ, в приложениях и службах. Безопасность содержимого ИИ Azure включает API текста и изображения, которые позволяют обнаруживать материалы, которые являются вредными. Интерактивная среда Content Safety Studio позволяет просматривать, изучать и пробовать пример кода для обнаружения вредного содержимого в разных модальности.

Чтобы приступить к работе, используйте следующие ресурсы.

| Задача | Рекомендуемые ресурсы |

|---|---|

| Узнайте больше и начните работу | Что такое безопасность контента в ИИ Azure? — Службы ИИ Azure | Microsoft Learn Использование безопасности содержимого на портале Azure AI Foundry |

Следующий шаг для защиты искусственного интеллекта

Продолжайте укреплять безопасность конечных узлов с использованием ресурсов нулевого доверия:

- Центр рекомендаций по нулю доверия

- Платформа внедрения нулевого доверия

- план развертывания в рамках концепции Zero Trust с Microsoft 365

- Реагирование на инциденты с помощью XDR и интегрированного SIEM

- применение принципов нулевого доверия к службам Azure