Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

Чтобы переместить определения заданий Spark (SJD) из Azure Synapse в Fabric, у вас есть два разных варианта:

- Вариант 1. Создание определения задания Spark вручную в Fabric.

- Вариант 2. Вы можете использовать скрипт для экспорта определений заданий Spark из Azure Synapse и импорта их в Fabric с помощью API.

Рекомендации по определению задания Spark см. в различиях между Azure Synapse Spark и Fabric.

Необходимые компоненты

Если у вас еще нет, создайте рабочую область Fabric в клиенте.

Вариант 1. Создание определения задания Spark вручную

Экспорт определения задания Spark из Azure Synapse:

- Откройте Synapse Studio: войдите в Azure. Перейдите в рабочую область Azure Synapse и откройте Synapse Studio.

- Найдите задание Python/Scala/R Spark: найдите и определите определение задания Python/Scala/R Spark, которое требуется перенести.

-

Экспорт конфигурации определения задания:

- В Synapse Studio откройте определение задания Spark.

- Экспортируйте или запишите параметры конфигурации, включая расположение файла скрипта, зависимости, параметры и другие важные сведения.

Чтобы создать новое определение задания Spark (SJD) на основе экспортированных данных SJD в Fabric:

- Доступ к рабочей области Fabric: войдите в Fabric и получите доступ к рабочей области.

-

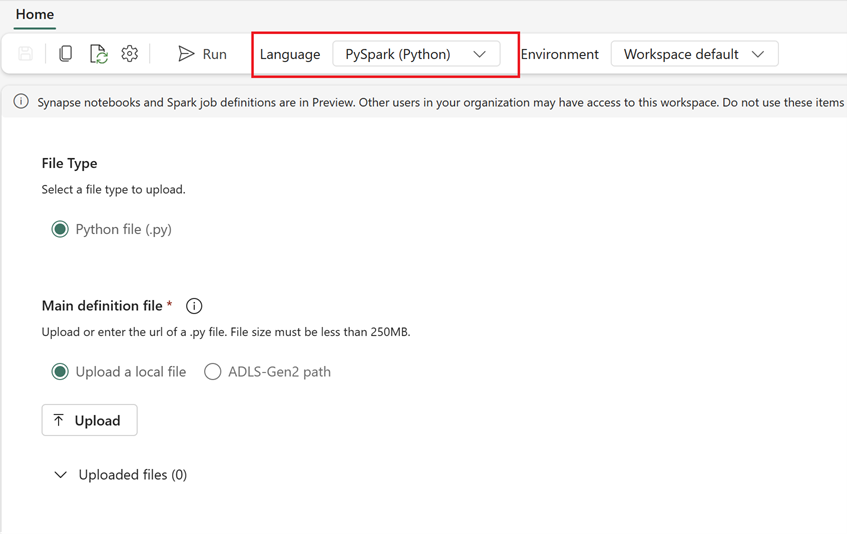

Создайте новое определение задания Spark в Fabric:

- В Fabric перейдите на Инжиниринг данных домашнюю страницу.

- Выберите определение задания Spark.

- Настройте задание с помощью информации, экспортируемой из Synapse, включая расположение скрипта, зависимости, параметры и параметры кластера.

- Адаптация и тестирование. Сделайте любую необходимую адаптацию к скрипту или конфигурации в соответствии с средой Fabric. Проверьте задание в Fabric, чтобы убедиться, что он работает правильно.

После создания определения задания Spark проверьте зависимости:

- Убедитесь, что используется та же версия Spark.

- Проверьте наличие файла основного определения.

- Проверьте наличие ссылочных файлов, зависимостей и ресурсов.

- Связанные службы, подключения источника данных и точки подключения.

Узнайте больше о создании определения задания Apache Spark в Fabric.

Вариант 2. Использование API Fabric

Выполните следующие ключевые действия для миграции:

- Предварительные требования.

- Шаг 1. Экспорт определения задания Spark из Azure Synapse в OneLake (.json).

- Шаг 2. Импорт определения задания Spark автоматически в Fabric с помощью API Fabric.

Необходимые компоненты

Предварительные требования включают действия, которые необходимо учитывать перед началом миграции определения задания Spark в Fabric.

- Рабочая область Fabric.

- Если у вас еще нет, создайте в рабочей области lakehouse Fabric.

Шаг 1. Экспорт определения задания Spark из рабочей области Azure Synapse

Основной задачей шага 1 является экспорт определения задания Spark из рабочей области Azure Synapse в OneLake в формате JSON. Этот процесс выглядит следующим образом:

- 1.1) Импорт записной книжки миграции SJD в рабочую область Fabric . Эта записная книжка экспортирует все определения заданий Spark из заданной рабочей области Azure Synapse в промежуточный каталог в OneLake. API Synapse используется для экспорта SJD.

- 1.2) Настройте параметры в первой команде для экспорта определения задания Spark в промежуточное хранилище (OneLake). Это экспортирует только файл метаданных JSON. Следующий фрагмент кода используется для настройки параметров источника и назначения. Обязательно замените их собственными значениями.

# Azure config

azure_client_id = "<client_id>"

azure_tenant_id = "<tenant_id>"

azure_client_secret = "<client_secret>"

# Azure Synapse workspace config

synapse_workspace_name = "<synapse_workspace_name>"

# Fabric config

workspace_id = "<workspace_id>"

lakehouse_id = "<lakehouse_id>"

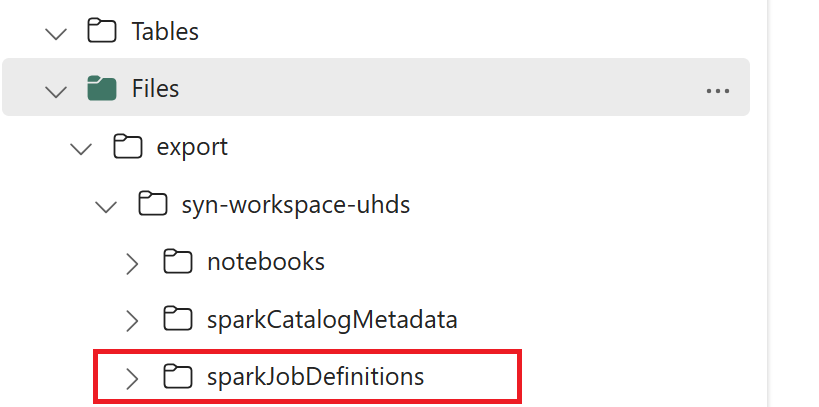

export_folder_name = f"export/{synapse_workspace_name}"

prefix = "" # this prefix is used during import {prefix}{sjd_name}

output_folder = f"abfss://{workspace_id}@onelake.dfs.fabric.microsoft.com/{lakehouse_id}/Files/{export_folder_name}"

- 1.3) Выполните первые две ячейки записной книжки экспорта и импорта, чтобы экспортировать метаданные определения задания Spark в OneLake. После завершения ячеек создается эта структура папок в промежуточном выходном каталоге.

Шаг 2. Импорт определения задания Spark в Fabric

Шаг 2— при импорте определений заданий Spark из промежуточного хранилища в рабочую область Fabric. Этот процесс выглядит следующим образом:

- 2.1) Проверьте конфигурации в версии 1.2, чтобы убедиться, что указана правильная рабочая область и префикс для импорта определений заданий Spark.

- 2.2) Запустите третью ячейку записной книжки экспорта и импорта, чтобы импортировать все определения заданий Spark из промежуточного расположения.

Примечание.

Параметр экспорта выводит файл метаданных JSON. Убедитесь, что исполняемые файлы определения задания Spark, ссылочные файлы и аргументы доступны из Fabric.