Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

ОБЛАСТЬ ПРИМЕНЕНИЯ: Фабрика данных Azure

Фабрика данных Azure  Azure Synapse Analytics

Azure Synapse Analytics

Совет

Попробуйте использовать фабрику данных в Microsoft Fabric, решение для аналитики с одним интерфейсом для предприятий. Microsoft Fabric охватывает все, от перемещения данных до обработки и анализа данных в режиме реального времени, бизнес-аналитики и отчетности. Узнайте, как бесплатно запустить новую пробную версию !

В этом быстром старте объясняется, как с помощью шаблона Azure Resource Manager (ARM) создать фарбрику данных Azure. Конвейер, который вы создадите в этой фабрике данных, копирует данные из одной папки в другую в хранилище BLOB-объектов Azure. Инструкции по преобразованию данных с помощью фабрики данных Azure см. в руководстве по преобразованию данных с помощью Spark.

Шаблон Azure Resource Manager — это файл нотации объектов JavaScript (JSON), который определяет инфраструктуру и конфигурацию проекта. В шаблоне используется декларативный синтаксис. Вы описываете предполагаемое развертывание без написания последовательности команд программирования для создания развертывания.

Примечание.

Эта статья не содержит подробных сведений о службе фабрики данных. Общие сведения о службе фабрики данных Azure см. в статье Введение в фабрику данных Azure.

Если среда соответствует предварительным требованиям и вы знакомы с использованием шаблонов ARM, нажмите кнопку Развертывание в Azure. Шаблон откроется на портале Azure.

Предварительные требования

Подписка Azure.

Если у вас нет подписки Azure, создайте бесплатную учетную запись, прежде чем приступить к работе.

Создание файла

Откройте текстовый редактор, например Блокнот, и создайте файл emp.txt с таким содержимым:

John, Doe

Jane, Doe

Сохраните файл в папкеC:\ADFv2QuickStartPSH. (Если папка не существует, создайте ее.)

Проверка шаблона

Шаблон, используемый в этом кратком руководстве, взят из шаблонов быстрого запуска Azure.

{

"$schema": "https://schema.management.azure.com/schemas/2019-04-01/deploymentTemplate.json#",

"contentVersion": "1.0.0.0",

"metadata": {

"_generator": {

"name": "bicep",

"version": "0.26.54.24096",

"templateHash": "17339534711754973978"

}

},

"parameters": {

"dataFactoryName": {

"type": "string",

"defaultValue": "[format('datafactory{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Data Factory Name"

}

},

"location": {

"type": "string",

"defaultValue": "[resourceGroup().location]",

"metadata": {

"description": "Location of the data factory."

}

},

"storageAccountName": {

"type": "string",

"defaultValue": "[format('storage{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Name of the Azure storage account that contains the input/output data."

}

},

"blobContainerName": {

"type": "string",

"defaultValue": "[format('blob{0}', uniqueString(resourceGroup().id))]",

"metadata": {

"description": "Name of the blob container in the Azure Storage account."

}

}

},

"variables": {

"dataFactoryLinkedServiceName": "ArmtemplateStorageLinkedService",

"dataFactoryDataSetInName": "ArmtemplateTestDatasetIn",

"dataFactoryDataSetOutName": "ArmtemplateTestDatasetOut",

"pipelineName": "ArmtemplateSampleCopyPipeline"

},

"resources": [

{

"type": "Microsoft.Storage/storageAccounts/blobServices",

"apiVersion": "2023-01-01",

"name": "[format('{0}/{1}', parameters('storageAccountName'), 'default')]",

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName'))]"

]

},

{

"type": "Microsoft.Storage/storageAccounts",

"apiVersion": "2023-01-01",

"name": "[parameters('storageAccountName')]",

"location": "[parameters('location')]",

"sku": {

"name": "Standard_LRS"

},

"kind": "StorageV2",

"properties": {

"minimumTlsVersion": "TLS1_2",

"supportsHttpsTrafficOnly": true,

"allowBlobPublicAccess": false

}

},

{

"type": "Microsoft.Storage/storageAccounts/blobServices/containers",

"apiVersion": "2023-01-01",

"name": "[format('{0}/{1}/{2}', parameters('storageAccountName'), 'default', parameters('blobContainerName'))]",

"dependsOn": [

"[resourceId('Microsoft.Storage/storageAccounts/blobServices', parameters('storageAccountName'), 'default')]"

]

},

{

"type": "Microsoft.DataFactory/factories",

"apiVersion": "2018-06-01",

"name": "[parameters('dataFactoryName')]",

"location": "[parameters('location')]",

"identity": {

"type": "SystemAssigned"

}

},

{

"type": "Microsoft.DataFactory/factories/linkedservices",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]",

"properties": {

"type": "AzureBlobStorage",

"typeProperties": {

"connectionString": "[format('DefaultEndpointsProtocol=https;AccountName={0};AccountKey={1}', parameters('storageAccountName'), listKeys(resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName')), '2023-01-01').keys[0].value)]"

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.Storage/storageAccounts', parameters('storageAccountName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/datasets",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryDataSetInName'))]",

"properties": {

"linkedServiceName": {

"referenceName": "[variables('dataFactoryLinkedServiceName')]",

"type": "LinkedServiceReference"

},

"type": "Binary",

"typeProperties": {

"location": {

"type": "AzureBlobStorageLocation",

"container": "[parameters('blobContainerName')]",

"folderPath": "input",

"fileName": "emp.txt"

}

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/linkedservices', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/datasets",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('dataFactoryDataSetOutName'))]",

"properties": {

"linkedServiceName": {

"referenceName": "[variables('dataFactoryLinkedServiceName')]",

"type": "LinkedServiceReference"

},

"type": "Binary",

"typeProperties": {

"location": {

"type": "AzureBlobStorageLocation",

"container": "[parameters('blobContainerName')]",

"folderPath": "output"

}

}

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/linkedservices', parameters('dataFactoryName'), variables('dataFactoryLinkedServiceName'))]"

]

},

{

"type": "Microsoft.DataFactory/factories/pipelines",

"apiVersion": "2018-06-01",

"name": "[format('{0}/{1}', parameters('dataFactoryName'), variables('pipelineName'))]",

"properties": {

"activities": [

{

"name": "MyCopyActivity",

"type": "Copy",

"typeProperties": {

"source": {

"type": "BinarySource",

"storeSettings": {

"type": "AzureBlobStorageReadSettings",

"recursive": true

}

},

"sink": {

"type": "BinarySink",

"storeSettings": {

"type": "AzureBlobStorageWriteSettings"

}

},

"enableStaging": false

},

"inputs": [

{

"referenceName": "[variables('dataFactoryDataSetInName')]",

"type": "DatasetReference"

}

],

"outputs": [

{

"referenceName": "[variables('dataFactoryDataSetOutName')]",

"type": "DatasetReference"

}

]

}

]

},

"dependsOn": [

"[resourceId('Microsoft.DataFactory/factories', parameters('dataFactoryName'))]",

"[resourceId('Microsoft.DataFactory/factories/datasets', parameters('dataFactoryName'), variables('dataFactoryDataSetInName'))]",

"[resourceId('Microsoft.DataFactory/factories/datasets', parameters('dataFactoryName'), variables('dataFactoryDataSetOutName'))]"

]

}

],

"outputs": {

"name": {

"type": "string",

"value": "[variables('pipelineName')]"

},

"resourceId": {

"type": "string",

"value": "[resourceId('Microsoft.DataFactory/factories/pipelines', parameters('dataFactoryName'), variables('pipelineName'))]"

},

"resourceGroupName": {

"type": "string",

"value": "[resourceGroup().name]"

},

"location": {

"type": "string",

"value": "[parameters('location')]"

}

}

}

В шаблоне определено пять ресурсов Azure:

- Microsoft.Storage/storageAccounts: определяет учетную запись хранения.

- Microsoft.DataFactory/factories: создание Фабрика данных Azure.

- Microsoft.DataFactory/factories/linkedServices: Создайте связанную службу для Фабрики Данных Azure.

- Microsoft.DataFactory/factories/datasets: Создание набора данных в фабрике данных Azure.

- Microsoft.DataFactory/factories/pipelines: создание конвейера Фабрика данных Azure.

Другие примеры шаблонов для службы "Фабрика данных Azure" можно найти в коллекции шаблонов быстрого запуска.

Развертывание шаблона

Выберите следующее изображение, чтобы войти на портал Azure и открыть шаблон. Этот шаблон создает учетную запись Azure Data Factory, учетную запись хранения и BLOB-контейнер.

Введите или выберите следующие значения.

Если значение не указано, используйте значения по умолчанию для создания ресурсов службы "Фабрика данных Azure".

- Подписка— выберите подписку Azure.

- Группа ресурсов: выберите "Создать", введите уникальное имя группы ресурсов и нажмите кнопку "ОК".

- Регион: выберите расположение. Например, Восточная часть США.

- Имя фабрики данных: Сохраните значение по умолчанию.

- Расположение: используйте значение по умолчанию.

- Имя учетной записи хранения: используйте значение по умолчанию.

- Контейнер Blob: используйте значение по умолчанию.

Просмотр развернутых ресурсов

Выберите Перейти к группе ресурсов.

Убедитесь, что Фабрика данных Azure успешно создана.

- Фабрика данных Azure называется в формате datafactory<uniqueid>.

Убедитесь, что учетная запись хранения успешно создана.

- Имя учетной записи хранения имеет формат storage<uniqueid>.

Выберите созданную учетную запись хранения и щелкните Контейнеры.

- На странице Контейнеры выберите контейнер блобов, который вы создали.

- Имя контейнера BLOB-объектов имеет формат blob<uniqueid>.

- На странице Контейнеры выберите контейнер блобов, который вы создали.

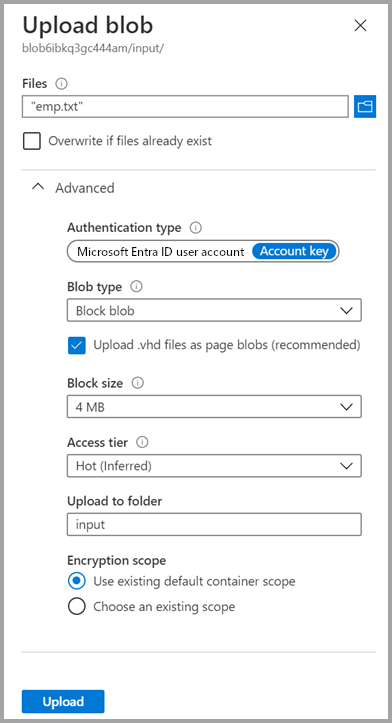

Отправка файла

На странице Контейнеры выберите Отправить.

В правой области выберите поле "Файлы ", а затем перейдите к файлу emp.txt , созданному ранее.

Разверните заголовок Дополнительно.

В поле Отправить в папку введите input.

Нажмите кнопку Отправить. В списке должен отобразиться файл emp.txt с состоянием отправки.

Щелкните значок Закрыть («X»), чтобы закрыть страницу Загрузки BLOB.

Не закрывайте страницу контейнера, так как здесь вы сможете проверить выходные данные в конце этого краткого руководства.

Триггер запуска

Перейдите на страницу Фабрики данных и выберите созданную вами фабрику данных.

Выберите Открыть на плитке Open Azure Data Factory Studio (Открыть студию Фабрики данных Azure).

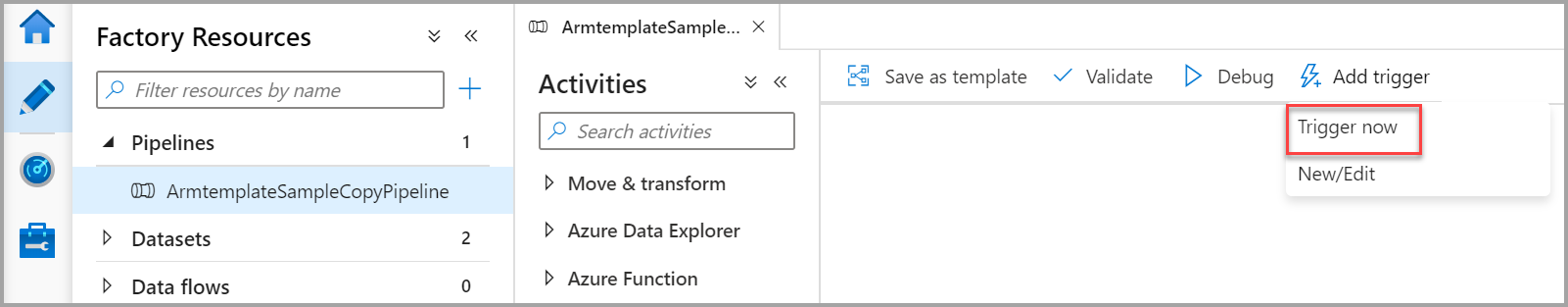

Выберите вкладку Автор

.

.Выберите созданный конвейер ArmtemplateSampleCopyPipeline.

Выберите Добавить триггер>Активировать сейчас.

На панели справа в разделе Запуск конвейера щелкните ОК.

Мониторинг конвейера

Выберите вкладку Мониторинг

.

.Вы видите запуски циклов активности, связанные с запуском конвейера. В этом кратком руководстве конвейер содержит только один тип действия: копирование. Поэтому вы видите выполнение именно этого действия.

Проверка файла выходных данных

Этот конвейер автоматически создает папку с результатами в контейнере объектов BLOB. Затем он копирует файл emp.txt из входной папки в выходную.

На портале Azure откройте страницу Контейнеры и нажмите кнопку Обновить, чтобы появилась папка output.

В списке папок выберите output.

Убедитесь, что файл emp.txt скопирован в папку output.

Очистка ресурсов

Вы можете очистить ресурсы, созданные в Quickstart, двумя способами. Вы можете удалить группу ресурсов Azure, которая содержит все связанные ресурсы. Если вы хотите сохранить другие ресурсы, удалите только фабрику данных, созданную в этом руководстве.

При удалении группы ресурсов будут удалены все входящие в нее ресурсы, включая фабрики данных. Выполните следующую команду, чтобы удалить всю группу ресурсов:

Remove-AzResourceGroup -ResourceGroupName $resourcegroupname

Если вам нужно удалить только фабрику данных, а не всю группу ресурсов, выполните следующую команду:

Remove-AzDataFactoryV2 -Name $dataFactoryName -ResourceGroupName $resourceGroupName

Связанный контент

В этом кратком руководстве вы создали Фабрику данных Azure с помощью шаблона ARM и проверили развертывание. Дополнительные сведения о службе "Фабрика данных Azure" и Azure Resource Manager см. в статьях ниже.

- Документация по фабрике данных Azure

- Сведения об Azure Resource Manager

- Изучите другие шаблоны ARM для службы "Фабрика данных Azure"