Примечание

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

В этой статье описывается, как настроить агент данных в Microsoft Fabric с помощью lakehouse в качестве источника данных. Чтобы проиллюстрировать процесс, сначала создадим озеро, а затем добавим в него данные. Затем мы создадим агент данных Fabric и настраиваем lakehouse в качестве источника данных. Если у вас уже есть семантическая модель Power BI (с необходимыми разрешениями на чтение и запись), хранилище или база данных KQL, вы можете выполнить те же действия после создания агента данных Fabric для добавления источников данных. Хотя шаги, показанные здесь, сосредоточены на хранилище данных типа lakehouse, процесс похож на процесс для других источников данных — вам просто нужно внести корректировки на основе вашего конкретного выбора.

Это важно

Эта функция доступна в предварительной версии.

Предпосылки

- Платный ресурс емкости типа Fabric F2 или выше

- Параметры клиента агента данных Fabric включены.

- Включен коммутатор клиента Copilot .

- Включена меж-географическая обработка для ИИ .

- Межрегиоционное хранение для искусственного интеллекта включено.

- По крайней мере одно из них: хранилище, озеро, одна или несколько семантических моделей Power BI или база данных KQL с данными.

- Семантические модели Power BI с помощью коммутатора клиента конечных точек XMLA включены для источников данных семантической модели Power BI.

Создание озера с помощью AdventureWorksLH

Сначала создайте озеро и заполните его необходимыми данными.

Если у вас уже есть экземпляр AdventureWorksLH в лейкхаусе (или складе), этот шаг можно пропустить. В противном случае можно использовать следующие инструкции из записной книжки Fabric для заполнения озёрного дома данными.

Создайте записную книжку в рабочей области, в которой вы хотите создать агент данных Fabric.

В левой части области обозревателя выберите +Источники данных. Этот параметр позволяет добавить существующий lakehouse или создать новый lakehouse. Для ясности создайте новое озеро и назначьте ему имя.

В верхней ячейке добавьте следующий фрагмент кода:

import pandas as pd from tqdm.auto import tqdm base = "https://synapseaisolutionsa.z13.web.core.windows.net/data/AdventureWorks" # load list of tables df_tables = pd.read_csv(f"{base}/adventureworks.csv", names=["table"]) for table in (pbar := tqdm(df_tables['table'].values)): pbar.set_description(f"Uploading {table} to lakehouse") # download df = pd.read_parquet(f"{base}/{table}.parquet") # save as lakehouse table spark.createDataFrame(df).write.mode('overwrite').saveAsTable(table)Выберите Запустить все.

Через несколько минут лейкхаус заполняется необходимыми данными.

Создание агента данных Fabric

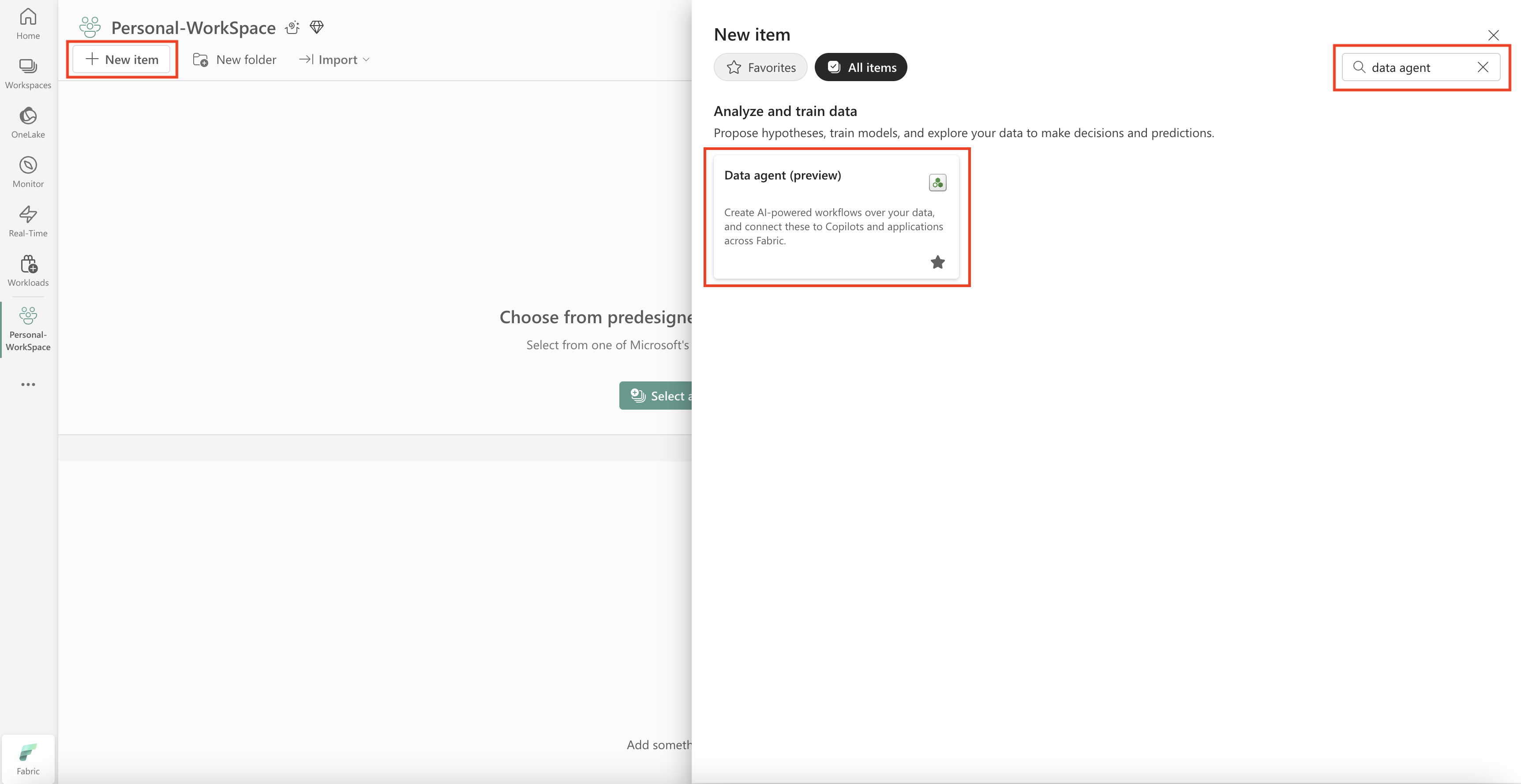

Чтобы создать нового агента данных Fabric, перейдите в рабочую область и нажмите кнопку + Новый элемент, как показано на этом снимке экрана.

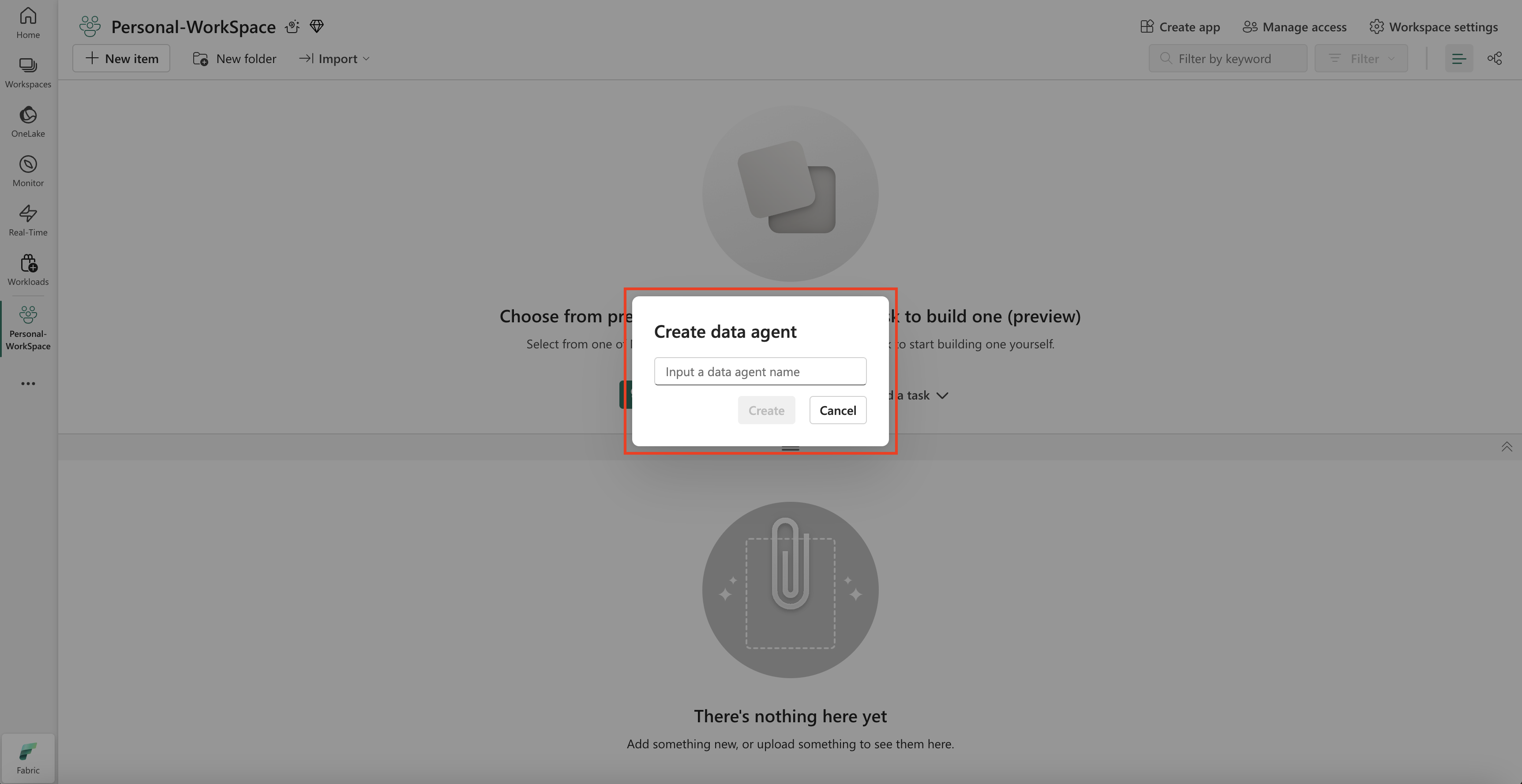

На вкладке "Все элементы" найдите агент данных Fabric, чтобы найти соответствующий параметр. После выбора запрос запрашивает указать имя агента данных Fabric, как показано на снимке экрана:

После ввода имени выполните следующие действия, чтобы настроить агента данных Fabric в соответствии с вашими конкретными требованиями.

Выбор данных

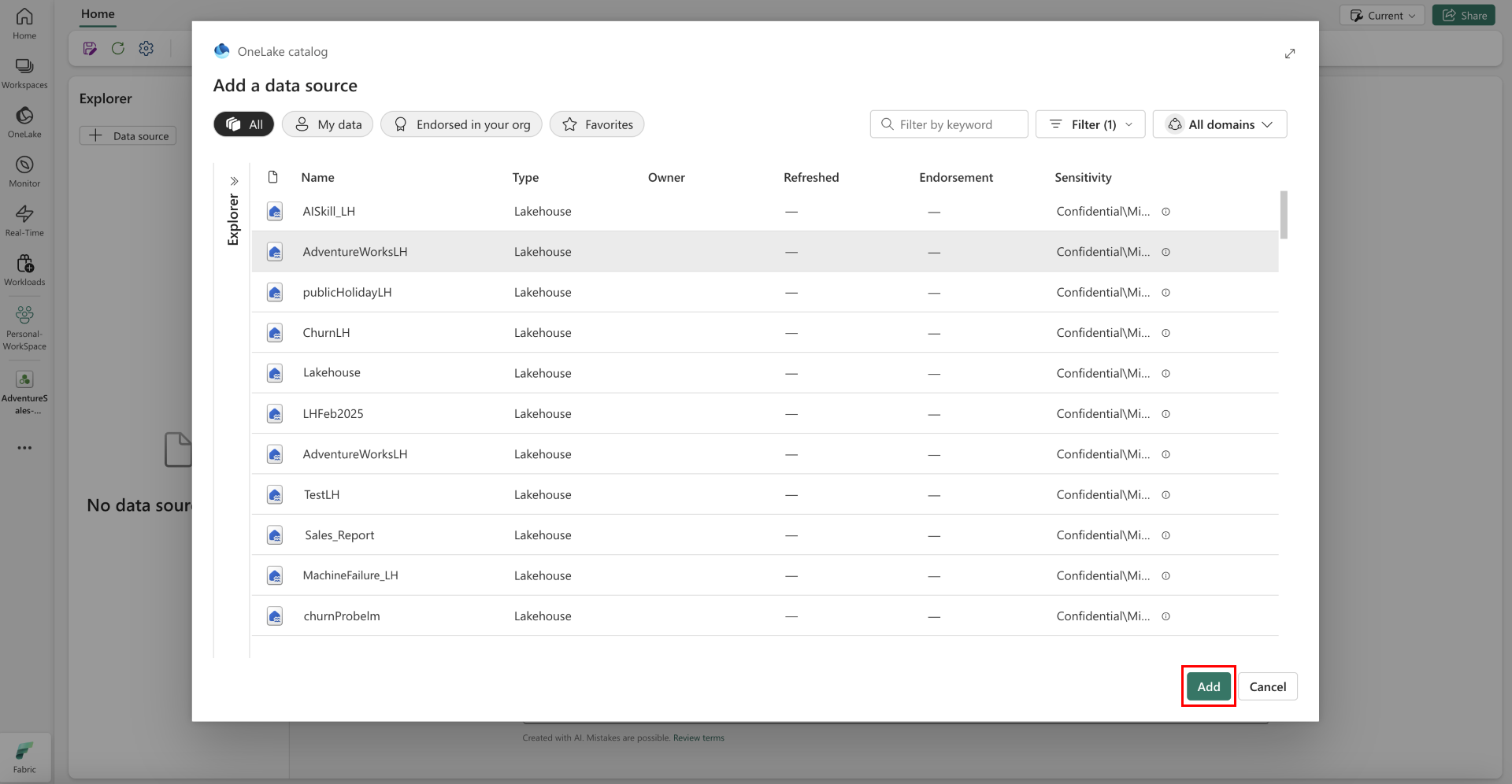

Выберите озерный дом, созданный на предыдущем шаге, и нажмите "Добавить", как показано на следующем снимке экрана.

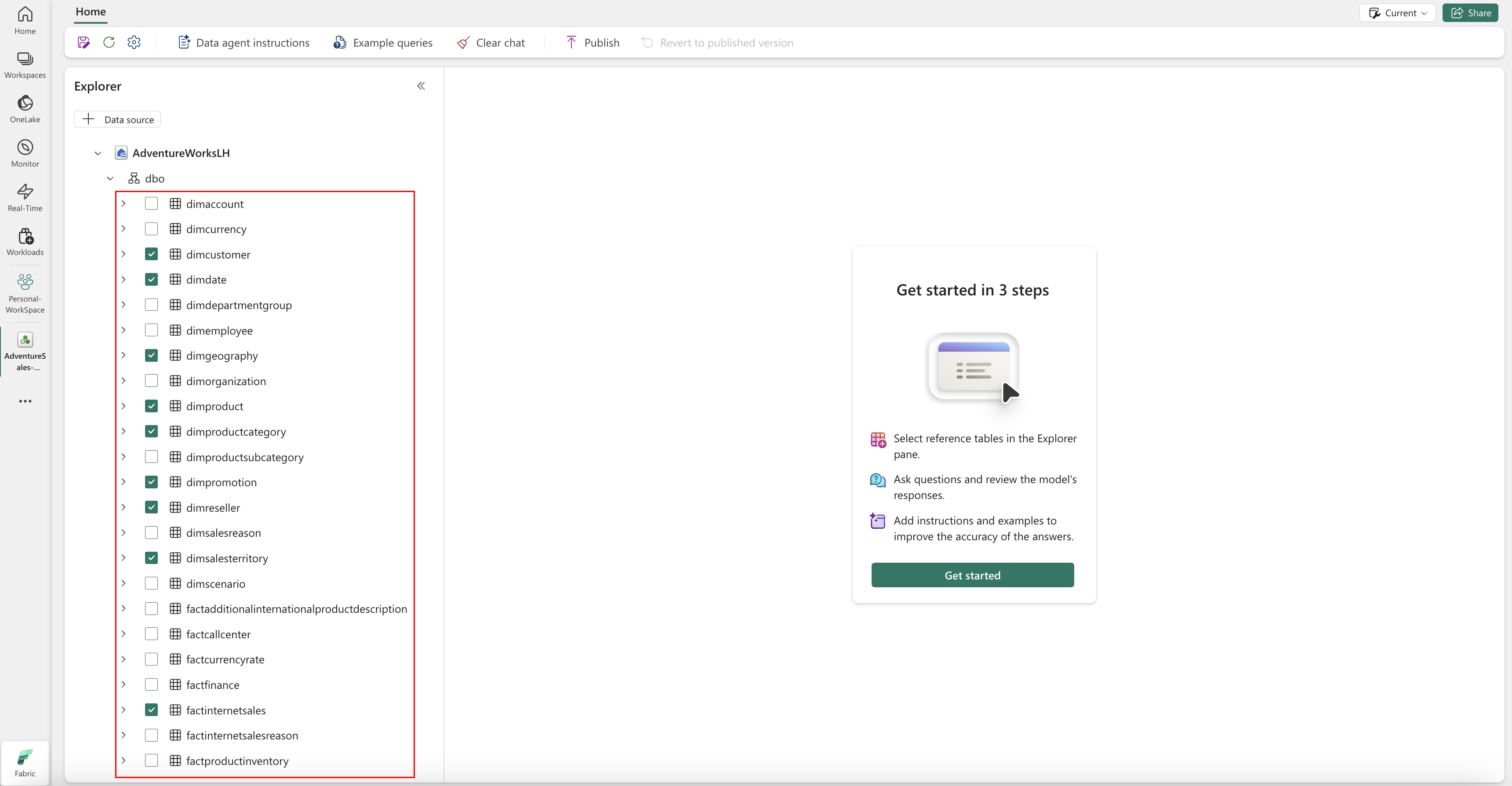

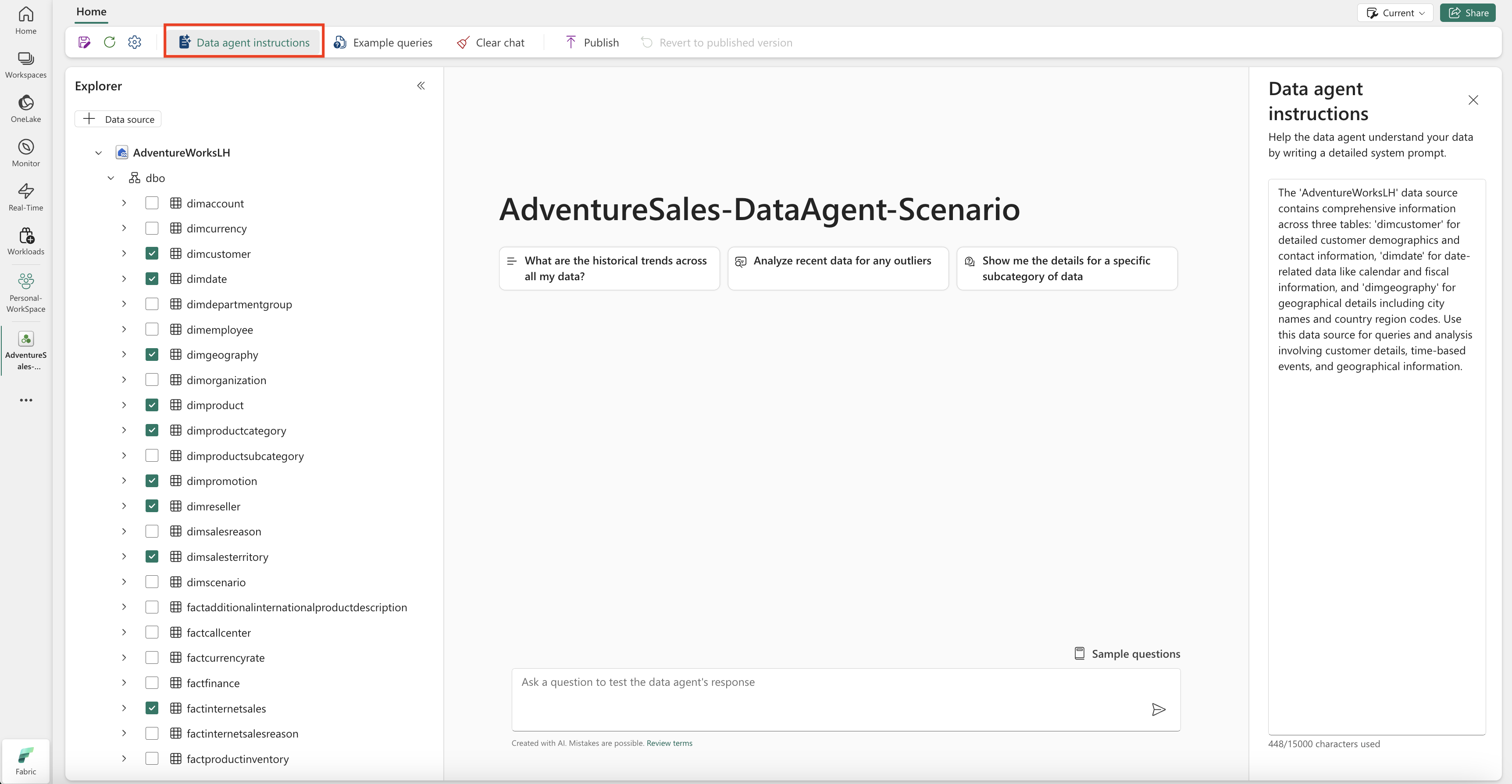

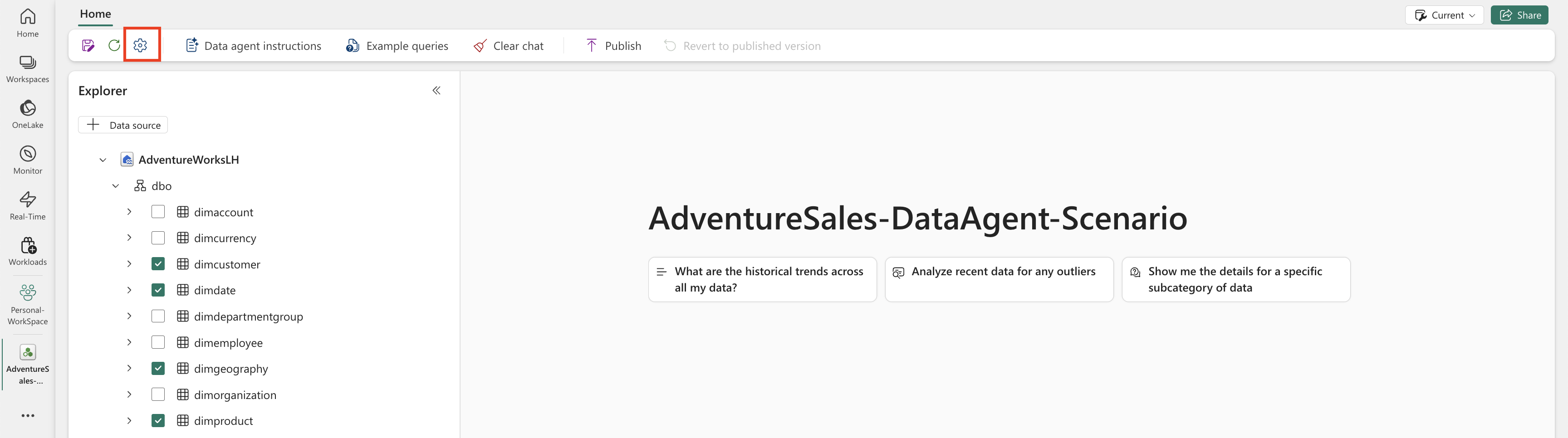

После добавления lakehouse в качестве источника данных, на панели Explorer в левой части страницы агента данных Fabric отображается имя lakehouse. Выберите lakehouse, чтобы просмотреть все доступные таблицы. Установите флажки, чтобы выбрать таблицы, которые нужно сделать доступными для ИИ. Для этого сценария выберите следующие таблицы:

dimcustomerdimdatedimgeographydimproductdimproductcategorydimpromotiondimresellerdimsalesterritoryfactinternetsalesfactresellersales

Укажите инструкции

Чтобы добавить инструкции агента данных Fabric, нажмите кнопку Инструкции агента данных, чтобы открыть панель инструкций агента данных Fabric справа. Вы можете добавить следующие инструкции.

Источник данных AdventureWorksLH содержит сведения из трех таблиц:

-

dimcustomer, для подробной информации о демографии и контактной информации клиентов -

dimdate, для данных, связанных с датой, например, календарная и финансовая информация -

dimgeographyдля получения географических сведений, включая названия городов и коды регионов страны.

Используйте этот источник данных для запросов и анализа, включающих сведения о клиентах, событиях на основе времени и географических расположениях.

Укажите примеры

Чтобы добавить примеры запросов, нажмите кнопку Примеры запросов, чтобы открыть панель примеров справа. Эта область предоставляет параметры для добавления или изменения примеров запросов для всех поддерживаемых источников данных. Для каждого источника данных можно выбрать "Добавить или изменить примеры запросов" для ввода соответствующих примеров, как показано на следующем снимке экрана:

Скриншот, показывающий, где можно добавить примеры, которые вы предоставляете в ИИ.

Здесь необходимо добавить примеры запросов к созданному источнику данных Lakehouse.

Question: Calculate the average percentage increase in sales amount for repeat purchases for every zipcode. Repeat purchase is a purchase subsequent to the first purchase (the average should always be computed relative to the first purchase)

SELECT AVG((s.SalesAmount - first_purchase.SalesAmount) / first_purchase.SalesAmount * 100) AS AvgPercentageIncrease

FROM factinternetsales s

INNER JOIN dimcustomer c ON s.CustomerKey = c.CustomerKey

INNER JOIN dimgeography g ON c.GeographyKey = g.GeographyKey

INNER JOIN (

SELECT *

FROM (

SELECT

CustomerKey,

SalesAmount,

OrderDate,

ROW_NUMBER() OVER (PARTITION BY CustomerKey ORDER BY OrderDate) AS RowNumber

FROM factinternetsales

) AS t

WHERE RowNumber = 1

) first_purchase ON s.CustomerKey = first_purchase.CustomerKey

WHERE s.OrderDate > first_purchase.OrderDate

GROUP BY g.PostalCode;

Question: Show the monthly total and year-to-date total sales. Order by year and month.

SELECT

Year,

Month,

MonthlySales,

SUM(MonthlySales) OVER (PARTITION BY Year ORDER BY Year, Month ROWS BETWEEN UNBOUNDED PRECEDING AND CURRENT ROW) AS CumulativeTotal

FROM (

SELECT

YEAR(OrderDate) AS Year,

MONTH(OrderDate) AS Month,

SUM(SalesAmount) AS MonthlySales

FROM factinternetsales

GROUP BY YEAR(OrderDate), MONTH(OrderDate)

) AS t

Замечание

Добавление примеров пар запросов и вопросов в настоящее время не поддерживается для источников данных семантической модели Power BI.

Тестирование и изменение агента данных Fabric

Теперь, когда вы настроили агент данных Fabric, добавили инструкции агента данных Fabric и предоставили примеры запросов к lakehouse, вы можете взаимодействовать с ним, задавая вопросы и получая ответы. При продолжении тестирования можно добавить дополнительные примеры и уточнить инструкции, чтобы повысить производительность агента данных Fabric. Работайте вместе с коллегами, чтобы собирать отзывы, и, учитывая их отзывы, убедитесь, что предоставленные примеры запросов и инструкций соответствуют типам вопросов, которые они хотят задать.

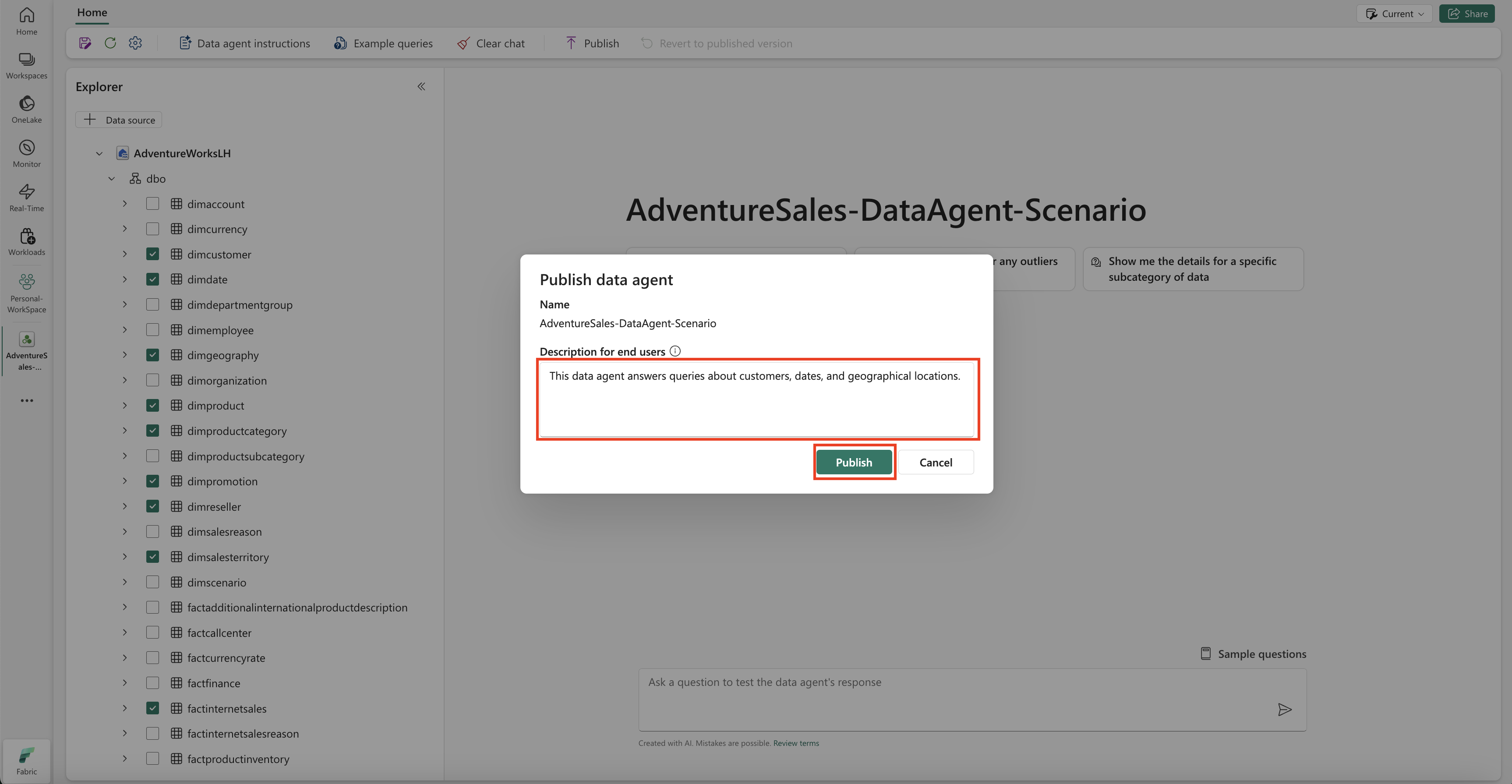

Опубликовать агента данных Fabric

После того как вы подтвердите производительность агента данных Fabric, вы можете опубликовать его, чтобы затем поделиться им с коллегами, которые хотят проводить вопросы и ответы по данным. В этом случае выберите "Опубликовать", как показано на снимке экрана:

Откроется окно агента публикации данных, как показано на данном снимке экрана:

В этом окне выберите Опубликовать, чтобы опубликовать агент данных Fabric. Появится опубликованный URL-адрес агента данных Fabric, как показано на этом снимке экрана:

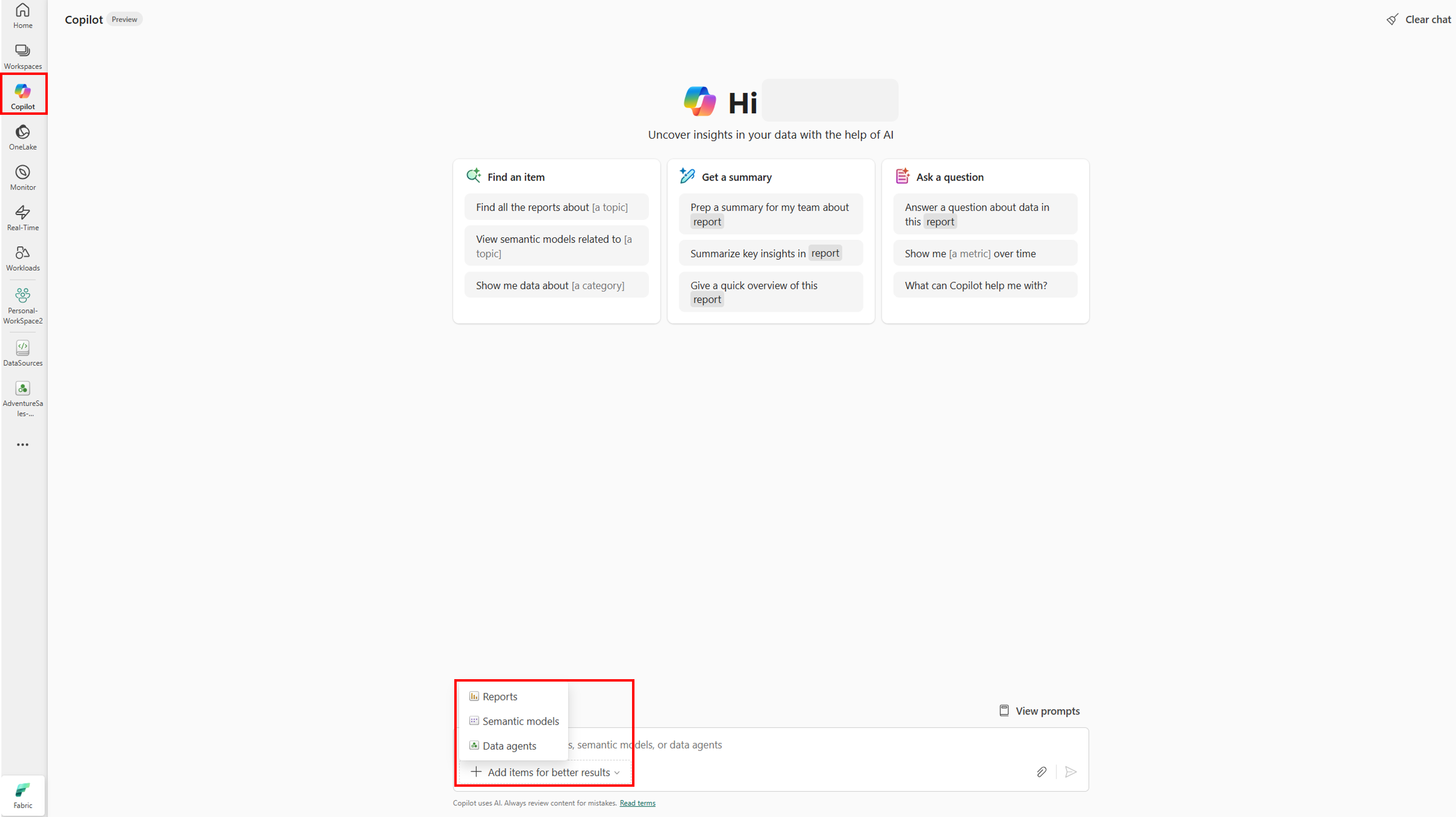

Использование агента данных Fabric в Copilot в Power BI

Вы можете использовать Copilot в Power BI для взаимодействия с агентом данных Fabric после публикации. С помощью Copilot в Power BI вы можете напрямую использовать агент данных и другие элементы (например, отчеты или семантические модели) без необходимости переключаться между ними.

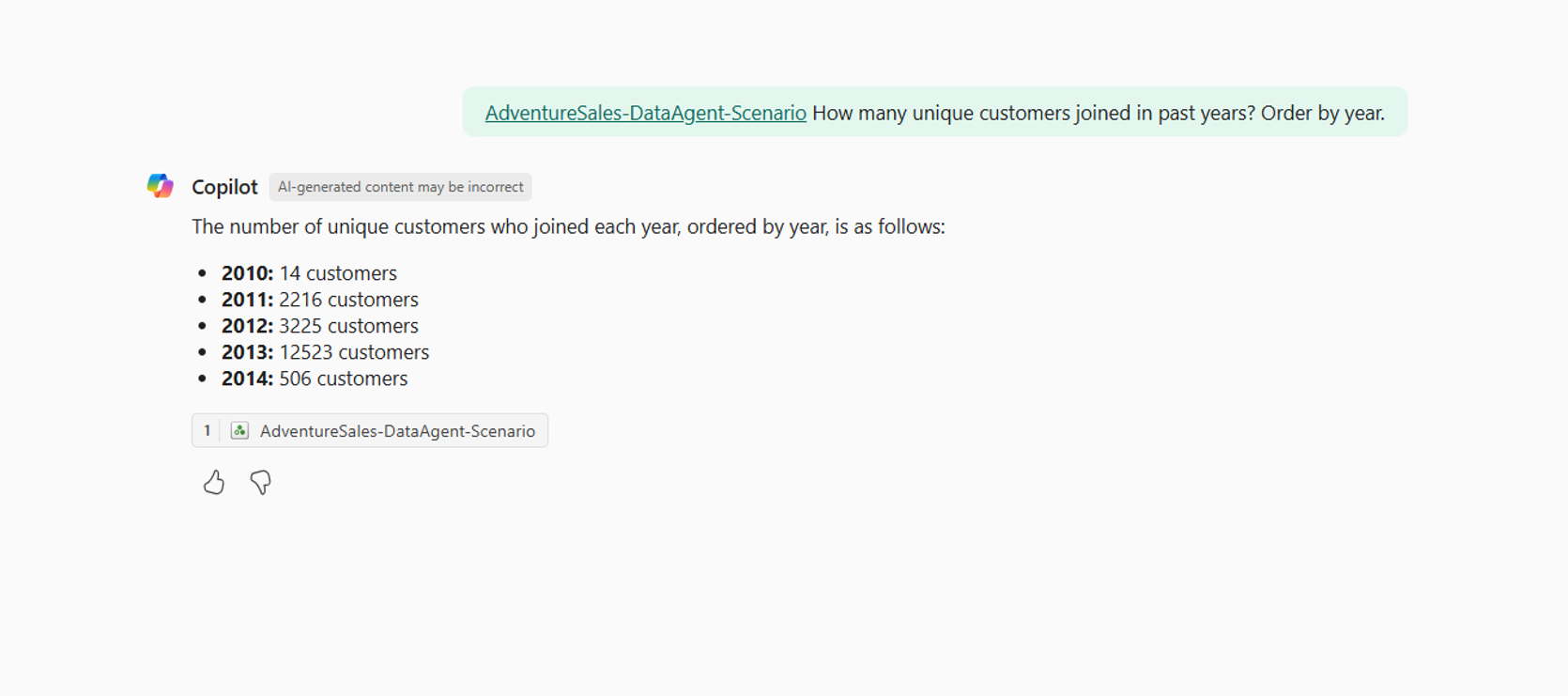

Нажмите кнопку Copilot на левой панели навигации, чтобы открыть Copilot в Power BI. Затем нажмите кнопку "Добавить элементы", чтобы улучшить результаты в текстовом поле внизу, чтобы добавить агент данных. Выберите агенты данных в открываемом окне. Вы можете видеть только тех агентов данных, к которым у вас есть разрешение на доступ. Выберите нужный агент данных и нажмите кнопку "Подтвердить". В этом примере показано, как работать с одним агентом данных, но можно добавить дополнительные элементы, например другие агенты данных, отчеты или семантические модели. На следующем снимках экрана показаны шаги с одним агентом данных:

Теперь, когда вы добавили агент данных в Copilot в Power BI, вы можете задать любые вопросы, связанные с агентом данных Fabric, как показано на следующем снимке экрана:

Программное использование агента данных Fabric

Агент данных Fabric можно использовать программным способом в записной книжке Fabric. Чтобы определить, имеет ли агент данных Fabric значение опубликованного URL-адреса, выберите "Параметры", как показано на следующем снимке экрана:

Перед публикацией агента данных Fabric у него нет опубликованного URL-адреса, как показано на скриншоте ниже.

Если вы еще не опубликовали агент данных Fabric, его можно опубликовать, выполнив инструкции, описанные в предыдущих шагах. Затем вы можете скопировать опубликованный URL-адрес и использовать его в записной книжке Fabric. Таким образом, можно запросить агента данных Fabric, обращаясь к его API в тетради Fabric. Вставьте скопированный URL-адрес в фрагмент кода. Затем замените вопрос любым запросом, соответствующим агенту данных Fabric. Этот пример использует \<generic published URL value\> в качестве URL-адреса.

%pip install "openai==1.70.0"

%pip install httpx==0.27.2

import requests

import json

import pprint

import typing as t

import time

import uuid

from openai import OpenAI

from openai._exceptions import APIStatusError

from openai._models import FinalRequestOptions

from openai._types import Omit

from openai._utils import is_given

from synapse.ml.mlflow import get_mlflow_env_config

from sempy.fabric._token_provider import SynapseTokenProvider

base_url = "https://<generic published base URL value>"

question = "What datasources do you have access to?"

configs = get_mlflow_env_config()

# Create OpenAI Client

class FabricOpenAI(OpenAI):

def __init__(

self,

api_version: str ="2024-05-01-preview",

**kwargs: t.Any,

) -> None:

self.api_version = api_version

default_query = kwargs.pop("default_query", {})

default_query["api-version"] = self.api_version

super().__init__(

api_key="",

base_url=base_url,

default_query=default_query,

**kwargs,

)

def _prepare_options(self, options: FinalRequestOptions) -> None:

headers: dict[str, str | Omit] = (

{**options.headers} if is_given(options.headers) else {}

)

options.headers = headers

headers["Authorization"] = f"Bearer {configs.driver_aad_token}"

if "Accept" not in headers:

headers["Accept"] = "application/json"

if "ActivityId" not in headers:

correlation_id = str(uuid.uuid4())

headers["ActivityId"] = correlation_id

return super()._prepare_options(options)

# Pretty printing helper

def pretty_print(messages):

print("---Conversation---")

for m in messages:

print(f"{m.role}: {m.content[0].text.value}")

print()

fabric_client = FabricOpenAI()

# Create assistant

assistant = fabric_client.beta.assistants.create(model="not used")

# Create thread

thread = fabric_client.beta.threads.create()

# Create message on thread

message = fabric_client.beta.threads.messages.create(thread_id=thread.id, role="user", content=question)

# Create run

run = fabric_client.beta.threads.runs.create(thread_id=thread.id, assistant_id=assistant.id)

# Wait for run to complete

while run.status == "queued" or run.status == "in_progress":

run = fabric_client.beta.threads.runs.retrieve(

thread_id=thread.id,

run_id=run.id,

)

print(run.status)

time.sleep(2)

# Print messages

response = fabric_client.beta.threads.messages.list(thread_id=thread.id, order="asc")

pretty_print(response)

# Delete thread

fabric_client.beta.threads.delete(thread_id=thread.id)

Связанный контент

- Концепция агента данных Fabric

- Создание агента данных Fabric