Примечание.

Для доступа к этой странице требуется авторизация. Вы можете попробовать войти или изменить каталоги.

Для доступа к этой странице требуется авторизация. Вы можете попробовать изменить каталоги.

ПРИМЕНЯЕТСЯ ДЛЯ: Все уровни управления API

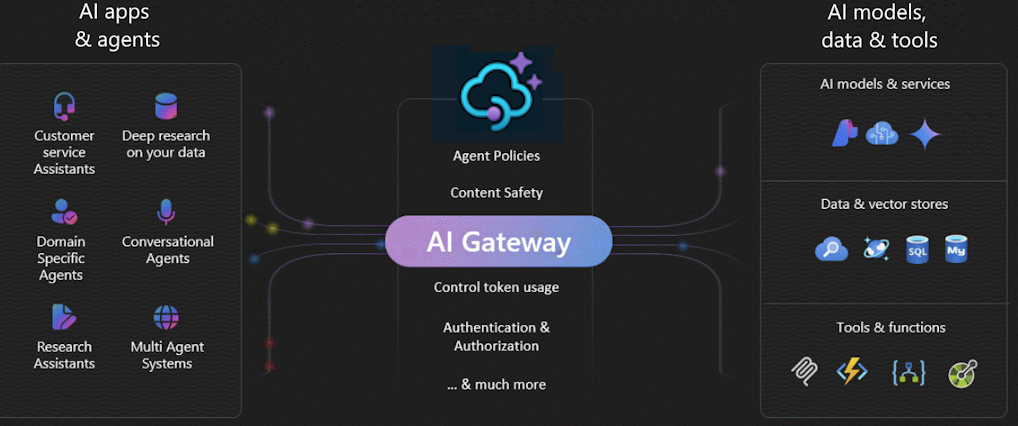

Шлюз искусственного интеллекта в службе "Управление API Azure" — это набор возможностей, которые помогают эффективно управлять серверными службами ИИ. Эти возможности помогают управлять, защищать, масштабировать, мониторить и управлять развертываниями больших языковых моделей, API ИИ и серверами протокола MCP, которые поддерживают интеллектуальные приложения и агентов.

Используйте шлюз ИИ для управления широким спектром конечных точек ИИ, в том числе:

- Azure AI Foundry и Azure OpenAI в развертываниях моделей Azure AI Foundry

- Развертывания API вывода модели искусственного интеллекта Azure

- Удаленные серверы MCP

- Модели и конечные точки, совместимые с OpenAI, размещенные у поставщиков, не связанных с Microsoft

- Локальные модели и конечные точки

Примечание

Шлюз ИИ, включая возможности сервера MCP, расширяет существующий шлюз API управления API; это не отдельное предложение. Связанные функции управления и разработчика находятся в Центре API Azure.

Зачем использовать шлюз ИИ?

Внедрение ИИ в организациях включает несколько этапов:

- Определение требований и оценка моделей искусственного интеллекта

- Создание приложений и агентов ИИ, которым требуется доступ к моделям и службам ИИ

- Эксплуатация и развертывание приложений ИИ и серверных компонентов в рабочей среде

По мере того как внедрение ИИ зрело, особенно в крупных предприятиях, шлюз ИИ помогает решить ключевые проблемы, помогая:

- Проверка подлинности и авторизация доступа к службам ИИ

- Балансировка нагрузки между несколькими конечными точками ИИ

- Мониторинг и ведение журналов взаимодействия с ИИ

- Управление использованием токенов и квот в нескольких приложениях

- Включение самообслуживания для команд разработчиков

Посредничество в трафике и контроль

С помощью шлюза искусственного интеллекта можно:

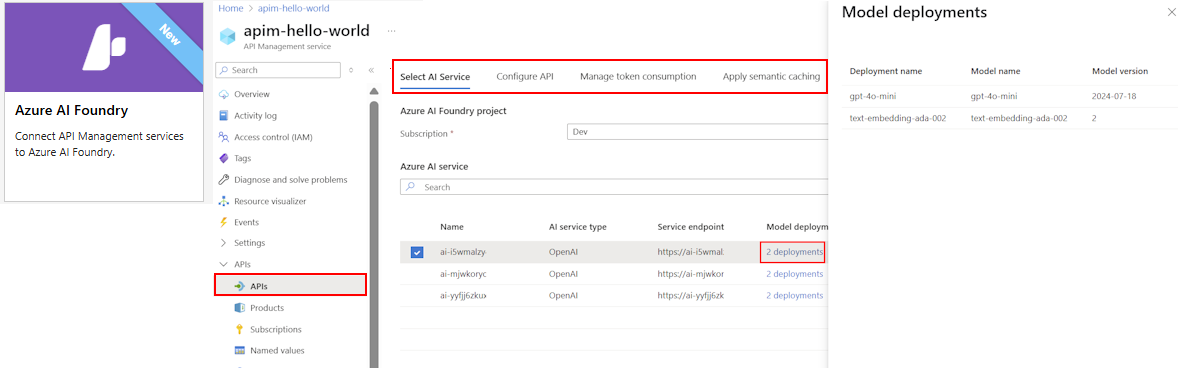

- Быстро импортируйте и настраивайте совместимые с OpenAI или прозрачные конечные точки LLM в качестве API.

- Управление моделями, развернутыми в Azure AI Foundry или поставщиками, такими как Amazon Bedrock

- Управление завершением чата, ответами и API в режиме реального времени

- Представьте ваши существующие REST API в качестве серверов MCP и поддержите передачу данных к серверам MCP.

Например, чтобы подключить модель, развернутую в AI Foundry или другом поставщике, управление API предоставляет упрощенные мастера для импорта схемы и настройки проверки подлинности в конечную точку ИИ с помощью управляемого удостоверения, удаляя необходимость ручной настройки. В рамках того же пользовательского интерфейса можно предварительно настроить политики для обеспечения масштабируемости, безопасности и наблюдаемости API.

Подробнее:

- Импорт API платформы AI Foundry

- Импорт API языковой модели

- Предоставление REST API в качестве сервера MCP

- Открытие доступа и управление существующим сервером MCP

Масштабируемость и производительность

Одним из основных ресурсов в создаваемых службах ИИ является токены. Azure AI Foundry и другие поставщики назначают квоты для развертываний модели в качестве токенов в минуту (TPM). Вы распределяете эти маркеры между потребителями модели, такими как различные приложения, команды разработчиков или отделы в компании.

Если у вас есть одно приложение, подключающееся к серверной части службы ИИ, вы можете управлять потреблением маркеров с помощью ограничения TPM, настроенного непосредственно в развертывании модели. Однако при росте портфеля приложений может потребоваться несколько приложений, вызывающих одну или несколько конечных точек службы ИИ. Эти конечные точки могут быть экземплярами единиц пропускной способности с оплатой по мере использования или подготовленными единицами пропускной способности (PTU). Необходимо убедиться, что одно приложение не использует всю квоту доверенного платформенного модуля и блокирует доступ к нужным серверным службам других приложений.

Ограничение скорости токенов и квоты

Настройте политику ограничения токенов в API LLM для управления и принудительного применения ограничений для каждого потребителя API на основе использования токенов службы AI. С помощью этой политики можно задать ограничение для TPM или квоту токена на указанный период, например, почасовую, ежедневную, еженедельную, ежемесячную или годовую.

Эта политика обеспечивает гибкость в установлении лимитов, основанных на токенах, для любого счетчика, например, для ключа подписки, исходящего IP-адреса или произвольного ключа, определяемого через выражение политики. Политика также включает предварительное вычисление маркеров запроса на стороне управления API Azure, минимизируя ненужные запросы к серверной части службы ИИ, если запрос уже превышает ограничение.

Пример, который приводится ниже, демонстрирует, как установить лимит TPM 500 на ключ подписки:

<llm-token-limit counter-key="@(context.Subscription.Id)"

tokens-per-minute="500" estimate-prompt-tokens="false" remaining-tokens-variable-name="remainingTokens">

</llm-token-limit>

Подробнее:

Семантическое кэширование

Семантическое кэширование — это метод, который повышает производительность API LLM путем кэширования результатов (завершения) предыдущих запросов и повторного их использования путем сравнения вектора запроса с предыдущими запросами. Этот метод уменьшает количество вызовов, сделанных в серверной части службы ИИ, улучшает время отклика для конечных пользователей и может помочь сократить затраты.

В службе "Управление API" включите семантическое кэширование с помощью Управляемого Redis Azure или другого внешнего кэша, совместимого с RediSearch и интегрированного с Azure API Management. Используя API встраивания, политики llm-semantic-cache-store и llm-semantic-cache-lookup сохраняют и извлекают семантически похожие завершения запросов из кэша. Данный подход обеспечивает повторное использование завершений, что приводит к снижению потребления токенов и улучшению производительности ответов.

Подробнее:

- Настройка внешнего кэша в службе "Управление API Azure"

- Включение семантического кэширования для API ИИ в службе API Management Azure

Собственные функции масштабирования в службе управления API

Управление API также предоставляет встроенные функции масштабирования, помогающие шлюзу обрабатывать большие объемы запросов к API ИИ. Эти функции включают автоматическое или ручное добавление единиц масштабирования шлюза и добавление региональных шлюзов для развертываний с несколькими регионами. Определенные возможности зависят от уровня службы управления API.

Подробнее:

- Обновление и масштабирование экземпляра службы управления API

- Развертывание экземпляра службы управления API в нескольких регионах

Примечание

Хотя управление API может масштабировать емкость шлюза, необходимо также масштабировать и распределять трафик на серверы ИИ для поддержания увеличенной нагрузки (см. раздел "Устойчивость). Например, чтобы воспользоваться преимуществами географического распределения системы в конфигурации с несколькими регионами, необходимо развернуть внутренние службы ИИ в том же регионе, что и шлюзы управления API.

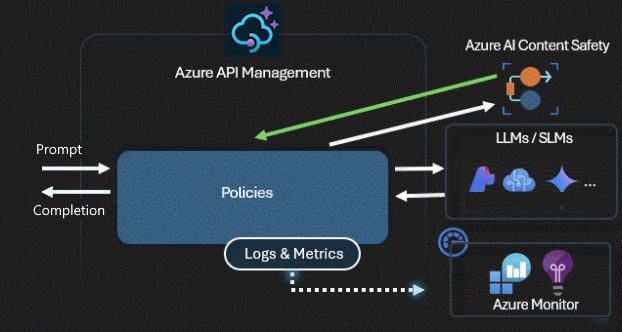

Безопасность и сохранность

Шлюз искусственного интеллекта защищает и управляет доступом к API ИИ. С помощью шлюза искусственного интеллекта можно:

- Для проверки подлинности в службах Azure AI используйте управляемые удостоверения, чтобы не требовались ключи API.

- Настройка авторизации OAuth для приложений и агентов ИИ для доступа к API-интерфейсам или серверам MCP с помощью диспетчера учетных данных управления API

- Применяйте политики для автоматической модерации запросов LLM с помощью Azure AI Content Safety

Подробнее:

- Проверка подлинности и авторизация доступа к API Azure OpenAI

- Сведения об учетных данных API и диспетчере учетных данных

- Принудительное применение проверок безопасности содержимого для запросов LLM

Resiliency

Одной из проблем при создании интеллектуальных приложений является обеспечение устойчивости приложений к сбоям серверной части и может обрабатывать высокие нагрузки. Настроив конечные точки LLM с внутренними серверами в службе "Управление API Azure", вы можете сбалансировать нагрузку между ними. Вы также можете определить правила разбиения цепи, чтобы остановить перенаправление запросов на серверные серверы службы ИИ, если они не реагируют.

Подсистема балансировки нагрузки

Серверный балансировщик нагрузки поддерживает циклический перебор, взвешенную, приоритетную и балансировку нагрузки с учетом сеансов. Вы можете определить стратегию распределения нагрузки, которая соответствует вашим конкретным требованиям. Например, определите приоритеты в конфигурации подсистемы балансировки нагрузки, чтобы обеспечить оптимальное использование определенных конечных точек Azure AI Foundry, особенно тех, которые приобрели в качестве экземпляров PTU.

Средство разбиения цепи

Серверный выключатель включает динамическую длительность поездки, применяя значения из Retry-After заголовка, предоставленного серверной частью. Эта функция обеспечивает точное и своевременное восстановление серверной части, максимизируя использование приоритетных серверных компонентов.

Подробнее:

Наблюдаемость и управление

Управление API предоставляет комплексные возможности мониторинга и аналитики для отслеживания шаблонов использования маркеров, оптимизации затрат, обеспечения соответствия политикам управления ИИ и устранения неполадок с API. Используйте следующие возможности:

- Журналирование подсказок и завершений в Azure Monitor

- Отслеживание метрик токенов для каждого потребителя в Application Insights

- Просмотр встроенной панели мониторинга

- Настройка политик с пользовательскими выражениями

- Управление квотами токенов в приложениях

Например, можно выпускать метрики токенов с помощью политики llm-emit-token-metric и добавлять настраиваемые измерения, которые можно использовать для фильтрации метрик в Azure Monitor. Следующий пример генерирует метрики токена с параметрами для IP-адреса клиента, ID API и ID пользователя (из пользовательского заголовка):

<llm-emit-token-metric namespace="llm-metrics">

<dimension name="Client IP" value="@(context.Request.IpAddress)" />

<dimension name="API ID" value="@(context.Api.Id)" />

<dimension name="User ID" value="@(context.Request.Headers.GetValueOrDefault("x-user-id", "N/A"))" />

</llm-emit-token-metric>

Кроме того, включите ведение журналов для API LLM в службе управления API Azure для отслеживания использования токенов, запросов и завершения операций в целях выставления счетов и аудита. После включения ведения журнала можно проанализировать журналы в Application Insights и использовать встроенную панель мониторинга в Управлении API для просмотра шаблонов потребления токенов в ваших AI API.

Подробнее:

- Использование токенов для ведения журнала, генерация подсказок и завершение

- Выявление метрик потребления токенов

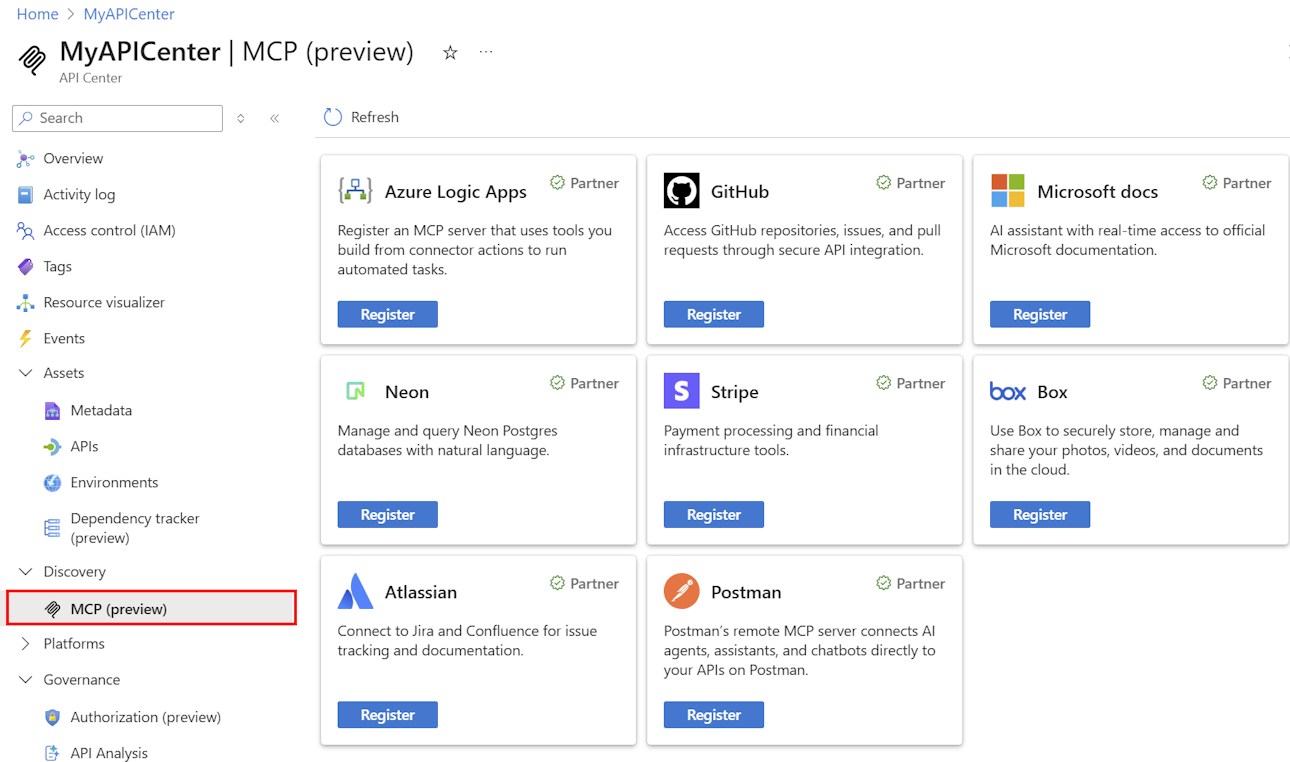

Опыт разработчика

Используйте шлюз ИИ и Центр API Azure для упрощения разработки и развертывания API-интерфейсов ИИ и серверов MCP. Помимо пользовательского интерфейса настройки импорта и политики для распространенных сценариев ИИ в службе управления API, вы можете воспользоваться следующими преимуществами:

- Простая регистрация API-интерфейсов и серверов MCP в каталоге организации в Центре API Azure

- Самостоятельный доступ к API и серверу MCP через порталы разработчиков в системе управления API и API-Центре

- Набор средств политики управления API для настройки

- Соединитель Api Center Copilot Studio для расширения возможностей агентов ИИ

Подробнее:

- Регистрация и обнаружение серверов MCP в Центре API

- Синхронизация API-интерфейсов и серверов MCP между управлением API и Центром API

- Портал разработчика службы управления API

- Портал Центра API

- Набор средств для управления политиками API Azure

- Соединитель Api Center Copilot Studio

Ранний доступ к функциям шлюза ИИ

В качестве клиента управления API вы можете получить ранний доступ к новым функциям и возможностям через канал выпуска шлюза искусственного интеллекта. Этот доступ позволяет попробовать последние инновации шлюза искусственного интеллекта, прежде чем они общедоступны и предоставить отзывы, чтобы помочь сформировать продукт.

Подробнее:

Лаборатории и примеры кода

- Лаборатории возможностей шлюза ИИ

- Семинар по шлюзу ИИ

- Azure OpenAI с управлением API (Node.js)

- Пример кода Python

Архитектура и проектирование

- Эталонная архитектура шлюза ИИ с помощью управления API

- Ускоритель зоны приёма шлюза AI хаба

- Проектирование и реализация решения шлюза с помощью ресурсов Azure OpenAI

- Использование шлюза перед несколькими развертываниями Azure OpenAI