Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

I modelli di Azure AI Foundry sono la destinazione unica per l'individuazione, la valutazione e la distribuzione di modelli avanzati di intelligenza artificiale, sia che si stia creando un copilota personalizzato, creando un agente, migliorando un'applicazione esistente o esplorando nuove funzionalità di intelligenza artificiale.

Con i modelli Foundry è possibile:

- Esplora un ricco catalogo di modelli all'avanguardia di Microsoft, OpenAI, DeepSeek, Hugging Face, Meta e altro ancora.

- Confrontare e valutare i modelli a fianco a fianco usando attività reali e dati propri.

- Distribuire con fiducia, grazie agli strumenti integrati per ottimizzare, osservare e garantire un'intelligenza artificiale responsabile.

- Scegliere il percorso: usare un modello personalizzato, usarne uno ospitato o integrarsi facilmente con i servizi di Azure.

- Sia che si sia uno sviluppatore, un data scientist o un architetto aziendale, Foundry Models offre flessibilità e controllo per creare soluzioni di intelligenza artificiale scalabili, in modo sicuro, responsabile e veloce.

Azure AI Foundry offre un catalogo completo di modelli di intelligenza artificiale. Sono disponibili oltre 1900 modelli che vanno da modelli di base, modelli di ragionamento, modelli linguistici piccoli, modelli multilingue, modelli specifici di dominio, modelli di settore e altro ancora.

Il nostro catalogo è organizzato in due categorie principali:

Comprendere la distinzione tra queste categorie consente di scegliere i modelli giusti in base ai requisiti specifici e agli obiettivi strategici.

Modelli venduti direttamente da Azure

Si tratta di modelli ospitati e venduti da Microsoft in Condizioni per i prodotti Microsoft. Questi modelli hanno subito una valutazione rigorosa e sono profondamente integrati nell'ecosistema di intelligenza artificiale di Azure. I modelli provengono da un'ampia gamma di provider principali e offrono un'integrazione avanzata, prestazioni ottimizzate e supporto diretto Microsoft, inclusi i contratti di servizio di livello aziendale.

Caratteristiche di questi modelli diretti:

- Supporto ufficiale di prima parte di Microsoft

- Alto livello di integrazione con i servizi e l'infrastruttura di Azure

- Esteso benchmarking e convalida delle prestazioni

- Conformità agli standard di intelligenza artificiale responsabile di Microsoft

- Scalabilità, affidabilità e sicurezza di livello aziendale

Questi modelli offrono anche il vantaggio di un rendimento previsto flessibile, il che significa che è possibile usare in modo flessibile la propria quota e le prenotazioni su tutti questi modelli.

Modelli di Partner e Comunità

Questi modelli costituiscono la maggior parte dei modelli di Azure AI Foundry. Questi modelli vengono forniti da organizzazioni di terze parti attendibili, partner, lab di ricerca e collaboratori della community. Questi modelli offrono funzionalità di IA specializzate e diversificate, che coprono un'ampia gamma di scenari, settori e innovazioni.

Caratteristiche dei modelli dei partner e della community:

- Sviluppato e supportato da partner esterni e collaboratori della community

- Gamma diversificata di modelli specializzati che rispondono a casi d'uso sia di nicchia che ampi.

- In genere convalidati dai provider stessi, con linee guida di integrazione fornite da Azure

- Innovazione guidata dalla community e rapida disponibilità di modelli all'avanguardia

- Integrazione standard di Intelligenza artificiale di Azure, con supporto e manutenzione gestiti dai rispettivi provider

I modelli sono distribuibili come opzioni di distribuzione di calcolo gestito o Standard (con pagamento in base al consumo). Il provider di modelli seleziona la modalità di distribuzione dei modelli.

Scelta tra modelli diretti e modelli di partner e community

Quando si selezionano modelli da Modelli di Azure AI Foundry, tenere presente quanto segue:

- Casi d'uso e requisiti: i modelli venduti direttamente da Azure sono ideali per scenari che richiedono un'integrazione approfondita di Azure, un supporto garantito e contratti di servizio aziendali. I modelli di ecosistema di Azure sono eccellenti in casi d'uso specializzati e scenari basati sull'innovazione.

- Aspettative di supporto: i modelli venduti direttamente da Azure sono dotati di robusto supporto e manutenzione forniti da Microsoft. Questi modelli sono supportati dai provider, con diversi livelli di contratto di servizio e strutture di supporto.

- Innovazione e specializzazione: i modelli dei partner e della community offrono accesso rapido alle innovazioni specializzate e alle funzionalità di nicchia spesso sviluppate da laboratori di ricerca leader e fornitori emergenti di intelligenza artificiale.

Raccolte di modelli

Il catalogo dei modelli organizza i modelli in raccolte diverse:

Modelli OpenAI di Azure disponibili esclusivamente in Azure: modelli OpenAI di Azure di punta disponibili tramite un'integrazione con Azure OpenAI nei modelli di Azure AI Foundry. Microsoft supporta questi modelli e il relativo uso in base alle condizioni del prodotto e al contratto di servizio per Azure OpenAI nei modelli di Azure AI Foundry.

Modelli aperti dell'hub Hugging Face: centinaia di modelli dell'hub Hugging Face per l'inferenza in tempo reale con l'ambiente di calcolo gestito. Hugging Face crea e gestisce i modelli elencati in questa raccolta. Per assistenza, usare il forum Hugging Face o il supporto di Hugging Face. Altre informazioni in Distribuire modelli aperti con Fonderia Azure AI.

È possibile inviare una richiesta per aggiungere un modello al catalogo modelli usando questo modulo.

Panoramica delle funzionalità del catalogo dei modelli

Il catalogo modelli nel Portale Fonderia Azure AI è l'hub ideato per individuare e usare un'ampia gamma di modelli per la creazione di applicazioni di IA generativa. Il catalogo dei modelli include centinaia di modelli tra provider di modelli, ad esempio Azure OpenAI, Mistral, Meta, Cohere, NVIDIA e Hugging Face, inclusi i modelli sottoposti a training da Microsoft. I modelli dei provider diversi da Microsoft sono prodotti non Microsoft, come definito nelle Condizioni per i prodotti Microsoft e sono soggetti alle condizioni fornite con il modello.

È possibile cercare e individuare modelli che soddisfano le proprie esigenze tramite la ricerca e i filtri delle parole chiave. Il catalogo dei modelli offre anche la classifica delle prestazioni del modello e le metriche di benchmark per i modelli selezionati. È possibile accedervi selezionando Sfoglia classifica e Confronta modelli. I dati di benchmark sono accessibili anche dalla scheda Benchmark della scheda modello.

Nei filtri del catalogo dei modelli sono disponibili:

- Raccolta: è possibile filtrare i modelli in base alla raccolta di provider di modelli.

- Settore: è possibile filtrare i modelli sottoposti a training su set di dati specifici del settore.

- Funzionalità: è possibile filtrare le caratteristiche univoche del modello, ad esempio il ragionamento e la chiamata agli strumenti.

- Opzioni di distribuzione: è possibile filtrare i modelli che supportano opzioni di distribuzione specifiche.

- Standard: questa opzione consente di pagare per ogni chiamata API.

- Provisioning: ideale per l'assegnazione dei punteggi in tempo reale per volumi coerenti di grandi dimensioni.

- Batch: ideale per i processi batch ottimizzati per i costi e non per latenza. Non viene fornito nessun supporto per il playground per la distribuzione batch.

- Calcolo gestito: questa opzione consente di distribuire un modello in una macchina virtuale di Azure. L'hosting e l'inferenza verranno fatturati.

- Attività di inferenza: è possibile filtrare i modelli in base al tipo di attività di inferenza.

- Ottimizzare le attività: è possibile filtrare i modelli in base al tipo di attività di ottimizzazione.

- Licenze: è possibile filtrare i modelli in base al tipo di licenza.

Nella scheda del modello sono disponibili:

- Fatti rapidi: verranno visualizzate informazioni chiave sul modello a colpo d'occhio.

- Dettagli: questa pagina contiene le informazioni dettagliate sul modello, tra cui descrizione, informazioni sulla versione, tipo di dati supportato e così via.

- Benchmark: sono disponibili metriche di benchmark delle prestazioni per i modelli selezionati.

- Distribuzioni esistenti: se il modello è già stato distribuito, è possibile trovarlo nella scheda Distribuzioni esistenti.

- Licenza: sono disponibili informazioni legali relative alle licenze dei modelli.

- Artefatti: questa scheda verrà visualizzata solo per i modelli aperti. È possibile visualizzare gli asset del modello e scaricarli tramite l'interfaccia utente.

Distribuzione del modello: calcolo gestito e distribuzioni standard

Oltre ai modelli OpenAI di Azure, il catalogo dei modelli offre due modi distinti per distribuire i modelli per l'uso: calcolo gestito e distribuzioni standard.

Le opzioni di distribuzione e le funzionalità disponibili per ciascun modello variano, come descritto nelle tabelle seguenti. Altre informazioni sull'elaborazione dati con le opzioni di distribuzione.

Funzionalità delle opzioni di distribuzione del modello

| Funzionalità | Calcolo gestito | Distribuzioni standard |

|---|---|---|

| Esperienza di distribuzione e fatturazione | I pesi del modello vengono distribuiti in macchine virtuali dedicate con ambienti di calcolo gestiti. Un ambiente di calcolo gestito, in cui possono essere presenti una o più distribuzioni, rende disponibile un'API REST per l'inferenza. Vengono addebitate le ore core della macchina virtuale usate dalle distribuzioni. | L'accesso ai modelli avviene tramite una distribuzione che effettua il provisioning di un'API per accedere al modello. L'API fornisce l'accesso al modello che Microsoft ospita e gestisce per l'inferenza. Vengono addebitati input e output alle API, in genere nei token. Le informazioni sui prezzi vengono fornite prima della distribuzione. |

| Autenticazione di API | Chiavi e autenticazione di Microsoft Entra. | Solo chiavi. |

| Sicurezza dei contenuti | Usare le API del servizio Sicurezza dei contenuti di Azure AI. | I filtri di Sicurezza dei contenuti di Azure AI sono integrati nelle API di inferenza. I filtri di Sicurezza dei contenuti di Azure AI sono fatturati separatamente. |

| Isolamento della rete | Configurare le reti gestite per gli hub di Fonderia Azure AI. | Gli ambienti di calcolo seguono l'impostazione del flag di accesso alla rete pubblica (PNA) dell'hub. Per altre informazioni, vedere la sezione Isolamento di rete per i modelli distribuiti tramite distribuzioni standard più avanti in questo articolo. |

Modelli disponibili per le opzioni di distribuzione supportate

Il Catalogo modelli offre due modi distinti per distribuire modelli dal catalogo per l'uso: risorse di calcolo gestite e distribuzioni standard. Le opzioni di distribuzione disponibili per ogni modello variano. Altre informazioni sulle caratteristiche delle opzioni di distribuzione e sulle opzioni disponibili per modelli specifici sono riportate nelle tabelle seguenti. Altre informazioni sull'elaborazione dati con le opzioni di distribuzione.

| Funzionalità | Calcolo gestito | Distribuzioni standard |

|---|---|---|

| Esperienza di distribuzione e fatturazione | I pesi del modello vengono distribuiti in macchine virtuali dedicate con endpoint online gestiti. L'endpoint online gestito, che può avere una o più distribuzioni, rende disponibile un'API REST per l'inferenza. Vengono fatturate le ore core della macchina virtuale usate dalle distribuzioni. | L'accesso ai modelli avviene tramite una distribuzione che effettua il provisioning di un'API per accedere al modello. L'API fornisce l'accesso al modello ospitato in un pool di GPU centrale, gestito da Microsoft, per l'inferenza. Questa modalità di accesso viene definita "Models as a Service". Vengono addebitati gli input e gli output alle API, in genere nei token; le informazioni sui prezzi vengono fornite prima della distribuzione. |

| Autenticazione di API | Chiavi e autenticazione con Microsoft Entra ID. Ulteriori informazioni. | Solo chiavi. |

| Sicurezza dei contenuti | Usare le API del servizio Sicurezza dei contenuti di Azure. | I filtri di Sicurezza dei contenuti di Azure AI sono integrati nelle API di inferenza. I filtri di Sicurezza dei contenuti di Azure AI possono essere fatturati separatamente. |

| Isolamento della rete | Rete virtuale gestita con endpoint online. Ulteriori informazioni. |

Calcolo gestito

La possibilità di distribuire modelli nell’ambiente di calcolo gestito è fornita dalle funzionalità della piattaforma Azure Machine Learning che consentono di integrare facilmente, nell'intero ciclo di vita GenAIOps (talvolta denominato LLMOps), l'ampia gamma di modelli del catalogo.

Disponibilità di modelli per la distribuzione come calcolo gestito

I modelli vengono resi disponibili tramite i registri di Azure Machine Learning, che consentono il primo approccio del Machine Learning all'hosting e alla distribuzione di asset di Machine Learning, ad esempio pesi modello, runtime di contenitori per l'esecuzione dei modelli, pipeline per la valutazione e l'ottimizzazione dei modelli e set di dati per benchmark ed esempi. Questi registri di Machine Learning si basano su un'infrastruttura di livello aziendale altamente scalabile che:

Offre artefatti del modello con accesso a bassa latenza a tutte le aree di Azure con replica geografica predefinita.

Supporta requisiti di sicurezza aziendali come la limitazione dell'accesso ai modelli con Criteri di Azure e la distribuzione sicura con reti virtuali gestite.

Distribuzione di modelli per l'inferenza con un ambiente di calcolo gestito

I modelli disponibili per la distribuzione nell’ambiente di calcolo gestito possono essere distribuiti in endpoint online di Azure Machine Learning per l'inferenza in tempo reale oppure essere usati per l'inferenza in batch di Azure Machine Learning per l'elaborazione dei dati in batch. La distribuzione in un ambiente di calcolo gestito richiede una quota macchina virtuale nella sottoscrizione di Azure per gli SKU specifici necessari per eseguire il modello in modo ottimale. Alcuni modelli consentono la distribuzione in una quota condivisa temporaneamente per il test del modello. Altre informazioni sulla distribuzione di modelli:

- Distribuire modelli Meta Llama

- Distribuire modelli aperti creati da Azure per intelligenza artificiale

- Distribuire modelli Hugging Face

Creare app di IA generativa con l'ambiente di calcolo gestito

Il prompt flow offre funzionalità per la creazione di prototipi, l'esecuzione di esperimenti, l'iterazione e la distribuzione di applicazioni di intelligenza artificiale. È possibile usare i modelli distribuiti con gli ambienti di calcolo gestiti in prompt flow con lo strumento Open Model LLM. È inoltre possibile usare l'API REST esposta dai calcoli gestiti nei più diffusi strumenti LLM, come LangChain, con l'estensione di Azure Machine Learning.

Sicurezza dei contenuti per i modelli distribuiti come ambiente di calcolo gestito

Il servizio Sicurezza dei contenuti di Azure AI (AACS) può essere usato per i modelli distribuiti in un ambiente di calcolo gestito per filtrare varie categorie di contenuti dannosi (ad esempio contenuti sessualmente espliciti, che incitano alla violenza, all’odio e all’autolesionismo) e minacce avanzate, ad esempio per rilevare il rischio di jailbreak o la presenza di testo appartenente a materiale protetto. È possibile consultare questo notebook per informazioni sull'integrazione con il servizio AACS per Llama 2 oppure usare lo strumento Sicurezza dei contenuti (testo) nel prompt flow per passare risposte dal modello ad AACS per poter essere esaminate. In questo caso, i costi vengono addebitati separatamente in base ai prezzi di AACS.

Distribuzioni standard con fatturazione Standard

Alcuni modelli nel catalogo dei modelli possono essere distribuiti come distribuzioni standard con fatturazione Standard; questo metodo di distribuzione è denominato distribuzioni standard. I modelli disponibili tramite MaaS sono ospitati nell'infrastruttura gestita da Microsoft, che consente l'accesso basato su API al modello del provider di modelli. L'accesso basato su API può ridurre sensibilmente i costi di accesso a un modello e semplificare notevolmente l'esperienza di provisioning. La maggior parte dei modelli MaaS prevede prezzi basati su token.

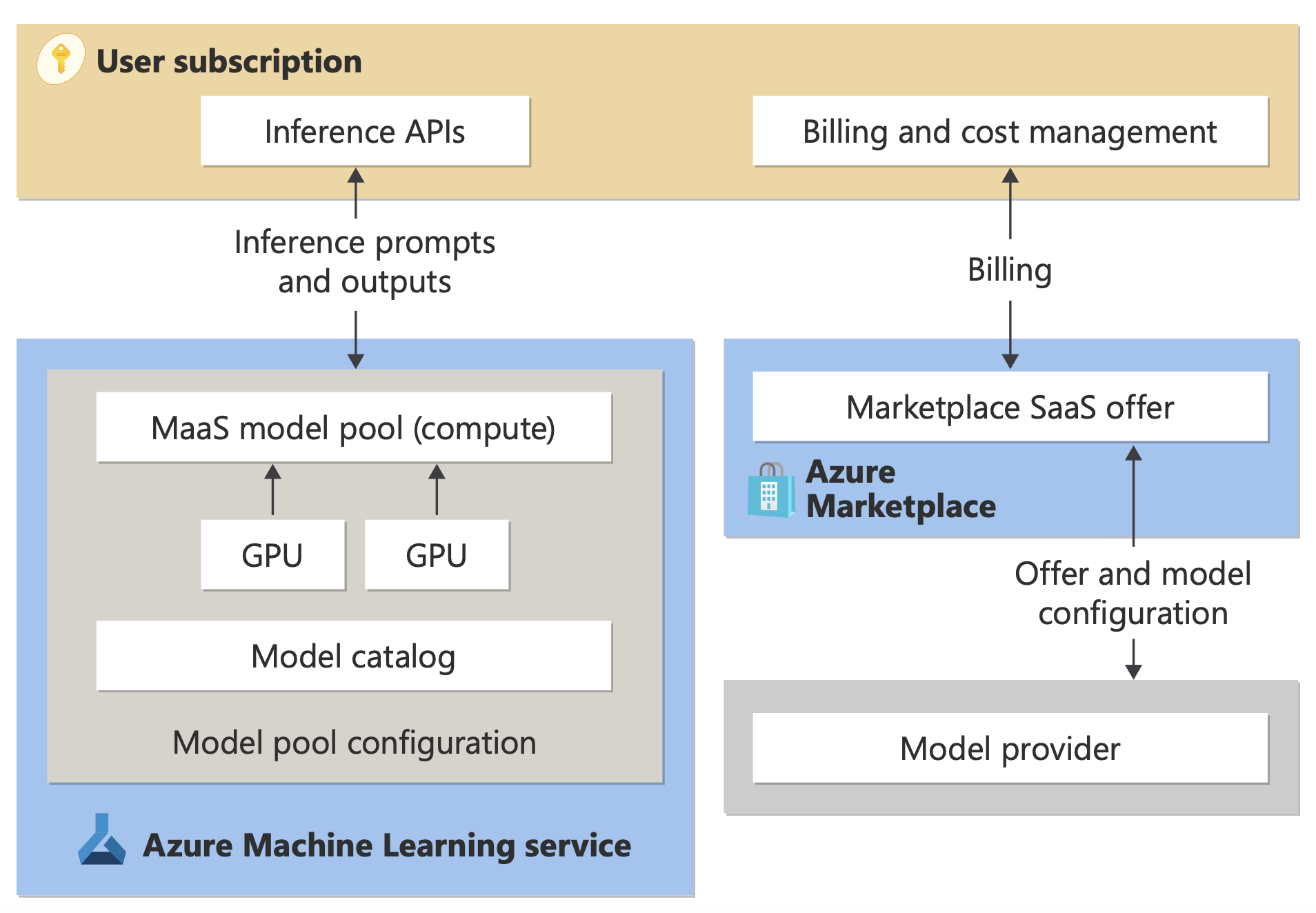

In che modo i modelli di terze parti vengono resi disponibili in MaaS?

I modelli disponibili per la distribuzione come distribuzioni standard con fatturazione Standard sono offerti dal provider di modelli, ma ospitati nell'infrastruttura di Azure gestita da Microsoft e accessibili tramite API. I provider di modelli definiscono le condizioni di licenza e impostano il prezzo per l'uso dei modelli, mentre il servizio Azure Machine Learning gestisce l'infrastruttura di hosting, rende disponibili le API di inferenza e svolge la funzione di elaboratore dati per le richieste inviate e i contenuti prodotti dai modelli distribuiti tramite MaaS. Per altre informazioni sull'elaborazione dati per MaaS, vedere l'articolo sulla privacy dei dati.

Annotazioni

Le sottoscrizioni cloud solution provider (CSP) non hanno la possibilità di acquistare modelli di distribuzione standard.

Fatturazione

L'esperienza di individuazione, sottoscrizione e utilizzo dei modelli distribuiti tramite MaaS si svolge nel Portale Fonderia Azure AI e nello studio di Azure Machine Learning. Gli utenti accettano le condizioni di licenza per l'utilizzo dei modelli. Le informazioni sui prezzi per l'utilizzo vengono fornite durante la distribuzione.

I modelli dei provider non Microsoft vengono fatturati tramite Azure Marketplace, in base alle Condizioni per l'utilizzo del Marketplace commerciale di Microsoft.

I modelli di Microsoft vengono fatturati tramite contatori di Azure come servizi di consumo di prima parte. Come descritto nelle Condizioni per i prodotti, si acquistano i servizi a consumo di prima parte usando i contatori di Azure, ma non sono soggetti alle condizioni del servizio di Azure. L'utilizzo di questi modelli è soggetto alle condizioni di licenza fornite.

Ottimizzazione dei modelli

Per i modelli disponibili tramite MaaS e supportano l'ottimizzazione, gli utenti possono sfruttare l'ottimizzazione ospitata con fatturazione Standard per personalizzare i modelli usando i dati forniti. Per altre informazioni, vedere Ottimizzare un modello Llama 2 nel portale di Azure AI Foundry.

RAG con modelli distribuiti come distribuzioni standard

Fonderia Azure AI consente agli utenti di usare gli indici vettoriali e il processo RAG (Retrieval Augmented Generation). I modelli che possono essere distribuiti come distribuzioni standard possono essere usati per generare incorporamenti e inferenze in base ai dati personalizzati per generare risposte specifiche del caso d'uso. Per altre informazioni, vedere Retrieval Augmented Generation e indici.

Disponibilità di offerte e modelli a livello di area

La fatturazione standard è disponibile solo per gli utenti la cui sottoscrizione di Azure appartiene a un account di fatturazione in un paese/area geografica in cui il provider di modelli ha reso disponibile l'offerta. Se l'offerta è disponibile nell'area pertinente, l'utente deve quindi avere un hub/progetto nell'area di Azure in cui il modello è disponibile per la distribuzione o l'ottimizzazione, a seconda delle esigenze. Per informazioni dettagliate, vedere Disponibilità dell'area per i modelli nelle distribuzioni standard.

Sicurezza dei contenuti per i modelli distribuiti tramite distribuzioni standard

Importante

Questa funzionalità è attualmente disponibile in anteprima pubblica. Questa versione di anteprima viene fornita senza contratto di servizio, pertanto se ne sconsiglia l’uso per i carichi di lavoro in ambienti di produzione. Alcune funzionalità potrebbero non essere supportate o potrebbero presentare funzionalità limitate.

Per altre informazioni, vedere le Condizioni supplementari per l'uso delle anteprime di Microsoft Azure.

Per i modelli linguistici distribuiti tramite l'API serverless, l'intelligenza artificiale di Azure implementa una configurazione predefinita dei filtri di moderazione del testo di Sicurezza dei contenuti di Intelligenza artificiale di Azure che rilevano contenuti dannosi come odio, autolesionismo, contenuto sessuale e violento. Per altre informazioni sul filtro dei contenuti, vedere Guardrails e controlli per i modelli venduti direttamente da Azure.

Suggerimento

Il filtro del contenuto non è disponibile per determinati tipi di modello distribuiti tramite l'API serverless. Questi tipi di modello includono modelli di incorporamento e modelli di serie temporali.

Il filtro del contenuto si verifica in modo sincrono quando i processi del servizio richiedono di generare contenuto. È possibile che vengano fatturati separatamente in base ai prezzi di Sicurezza dei contenuti di Azure AI per tale uso. È possibile disabilitare il filtro del contenuto per singoli endpoint serverless:

- Al momento della prima distribuzione di un modello linguistico

- In seguito, selezionando l'interruttore filtro contenuto nella pagina dei dettagli della distribuzione

Si supponga di decidere di usare un'API diversa dall'API di inferenza del modello per lavorare con un modello distribuito tramite un'API serverless. In una situazione di questo tipo, il filtro del contenuto non è abilitato a meno che non venga implementato separatamente usando Sicurezza dei contenuti di Intelligenza artificiale di Azure.

Per iniziare a usare Sicurezza dei contenuti di Azure AI, vedere Istruzioni della guida introduttiva: analizzare il contenuto di testo. Se non si usa il filtro del contenuto quando si usano modelli distribuiti tramite l'API serverless, si rischia di esporre gli utenti a contenuti dannosi.

Isolamento di rete per i modelli distribuiti tramite distribuzioni standard

Gli endpoint per i modelli distribuiti come distribuzioni standard seguono l'impostazione del flag di accesso alla rete pubblica (PNA) dell'area di lavoro in cui è presente la distribuzione. Per proteggere l'endpoint MaaS, disabilitare il flag PNA nell'area di lavoro. È possibile proteggere la comunicazione in ingresso da un client all'endpoint usando un endpoint privato per l'area di lavoro.

Per impostare il flag PNA per l'area di lavoro:

- Vai al portale di Azure .

- Cercare Azure Machine Learninge selezionare l'area di lavoro nell'elenco delle aree di lavoro.

- Nella pagina Panoramica usare il riquadro sinistro per passare a Impostazioni>rete.

- Nella scheda Accesso pubblico è possibile configurare le impostazioni per il flag di accesso alla rete pubblica.

- Salvare le modifiche. La propagazione delle modifiche può richiedere fino a cinque minuti.

Limitazioni

- Se si dispone di un'area di lavoro con un endpoint privato creata prima del 11 luglio 2024, i nuovi endpoint MaaS aggiunti a tale area di lavoro non seguiranno la configurazione di networking. È invece necessario creare un nuovo endpoint privato per l'area di lavoro e creare nuove distribuzioni standard nell'area di lavoro in modo che le nuove distribuzioni possano seguire la configurazione di rete dell'area di lavoro.

- Se si usa un'area di lavoro con distribuzioni MaaS creata prima del 11 luglio 2024 e si abilita un endpoint privato in tale area di lavoro, le distribuzioni MaaS esistenti non seguiranno la configurazione di networking dell'area di lavoro. Per le distribuzioni standard nell'area di lavoro per seguire la configurazione dell'area di lavoro, è necessario creare di nuovo le distribuzioni.

- Attualmente il supporto per i dati non è disponibile per le distribuzioni MaaS nelle aree di lavoro private, poiché il flag PNA è disabilitato per le aree di lavoro private.

- La propagazione di qualsiasi modifica della configurazione di rete (ad esempio, l'abilitazione o la disabilitazione del flag PNA) può richiedere fino a cinque minuti.