Nota

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare ad accedere o modificare le directory.

L'accesso a questa pagina richiede l'autorizzazione. È possibile provare a modificare le directory.

Si applica a:Istanza gestita di SQL di Azure

Questo articolo offre una panoramica dell'uso di opzioni di intelligenza artificiale ,ad esempio OpenAI e vettori, per creare applicazioni intelligenti con Istanza gestita di SQL di Azure.

Per campioni ed esempi, visitare il repository di campioni di SQL AI.

Informazioni generali

I modelli linguistici (LLM) di grandi dimensioni consentono agli sviluppatori di creare applicazioni basate su intelligenza artificiale con un’esperienza utente familiare.

L’uso di LLM nelle applicazioni offre un valore aggiunto e un’esperienza utente migliorata quando i modelli possono accedere ai dati corretti, al momento giusto, dal database dell’applicazione. Questo processo è noto come Generazione aumentata di recupero (RAG) e Istanza gestita di SQL di Azure offre molte funzionalità che supportano questo nuovo modello, rendendolo un database ideale per creare applicazioni intelligenti.

I collegamenti seguenti forniscono codice di esempio di varie opzioni per creare applicazioni intelligenti:

| Opzione IA | Descrizione |

|---|---|

| OpenAI di Azure | Generare incorporamenti per RAG e integrazioni con qualsiasi modello supportato da Azure OpenAI. |

| Vettori | Informazioni su come archiviare i vettori e usare le funzioni vettoriali nel database. |

| Ricerca di intelligenza artificiale di Azure | Usare il database insieme a Ricerca intelligenza artificiale di Azure per eseguire il training di LLM sui dati. |

| Applicazioni intelligenti | Informazioni su come creare una soluzione end-to-end con un modello comune che può essere replicato in qualsiasi scenario. |

Concetti chiave per l'implementazione di RAG con Azure OpenAI

Questa sezione include concetti chiave fondamentali per implementare RAG con Azure OpenAI in Istanza gestita di SQL di Azure.

Generazione aumentata di estrazione (RAG)

RAG è una tecnica che migliora la capacità dell’LLM di produrre risposte pertinenti e informative recuperando dati aggiuntivi da origini esterne. Ad esempio, RAG può eseguire query su articoli o documenti contenenti conoscenze specifiche del dominio correlate alla domanda o alla richiesta dell’utente. LLM può quindi usare i dati recuperati come riferimento durante la generazione della risposta. Ad esempio, un modello RAG semplice che usa Istanza gestita di SQL di Azure potrebbe essere:

- Inserire dati in una tabella.

- Collegare Istanza gestita di SQL di Azure a Ricerca di intelligenza artificiale di Azure.

- Creare un modello GPT4 di Azure OpenAI e collegarlo a Azure AI Search.

- Chattare e fare domande sui dati usando il modello OpenAI di Azure addestrato sia dalla tua applicazione che da Istanza gestita di Azure SQL.

Il modello RAG, con progettazione dei prompt, mira a migliorare la qualità della risposta offrendo informazioni più contestuali al modello. RAG consente al modello di applicare una knowledge base più ampia incorporando origini esterne pertinenti nel processo di generazione, ottenendo risposte più complete e informate. Per altre informazioni sui LLM di grounding, vedere LLM di grounding - Hub della community Microsoft.

Comandi e ingegneria dei comandi

Per prompt si intende testo o informazioni specifiche che fungono da istruzione a un LLM o come dati contestuali su cui l’LLM può basarsi. Può assumere varie forme, ad esempio una domanda, un’istruzione o anche un frammento di codice.

Di seguito è riportato un elenco di prompt che possono essere usati per generare una risposta da un LLM:

- Istruzioni: fornire direttive all’LLM

- Contenuto primario: fornisce informazioni all’LLM per l’elaborazione

- Esempi: consentono di definire la condizione del modello per un'attività o un processo specifico

- Segnali: indirizzano l'output dell'LLM nella direzione giusta

- Contenuto di supporto: rappresenta informazioni aggiuntive che l'LLM può utilizzare per generare l'output

Il processo di creazione di prompt validi per uno scenario è denominato progettazione di prompt. Per altre informazioni sulle richieste e sulle procedure consigliate per la progettazione dei prompt, vedere Servizio OpenAI di Azure.

Token

I token sono piccoli blocchi di testo generati suddividendo il testo di input in segmenti più piccoli. Questi segmenti possono essere parole o gruppi di caratteri, che variano in lunghezza da un singolo carattere a un'intera parola. Ad esempio, la parola hamburger verrebbe suddivisa in token come ham, bur e ger mentre una parola breve e comune come pear verrebbe considerata un singolo token.

In Azure OpenAI il testo di input fornito all'API viene trasformato in token (tokenizzati). Il numero di token elaborati in ogni richiesta API dipende da fattori quali la lunghezza dei parametri di input, output e richiesta. La quantità di token elaborati influisce anche sul tempo di risposta e sulla produttività dei modelli. Vi sono limiti al numero di token che ogni modello può accettare in una singola richiesta/risposta da Azure OpenAI. Per altre informazioni, vedere Quote e limiti del Servizio OpenAI di Azure.

Vettori

I vettori sono matrici ordinate di numeri (in genere float) che possono rappresentare informazioni su alcuni dati. Ad esempio, un’immagine può essere rappresentata come vettore di valori pixel oppure una stringa di testo come un vettore o valori ASCII. Il processo per trasformare i dati in un vettore è denominato vettorializzazione. Per altre informazioni, vedere Esempi di vettori.

L'uso dei dati vettoriali è più semplice con l'introduzione del tipo di dati vettoriale e delle funzioni vettoriali.

Integrazioni

Gli incorporamenti sono vettori che rappresentano caratteristiche importanti dei dati. Gli incorporamenti vengono spesso appresi con un modello di Deep Learning e i modelli di apprendimento automatico e intelligenza artificiale li usano come funzionalità. Gli incorporamenti possono inoltre acquisire la somiglianza semantica tra concetti simili. Ad esempio, durante la generazione di un incorporamento per le parole person e human, ci si aspetterebbe che gli incorporamenti (rappresentazione vettoriale) siano simili in valore, poiché anche le parole sono semanticamente simili.

Azure OpenAI offre modelli per creare incorporamenti da dati di testo. Il servizio suddivide il testo in token e genera incorporamenti usando modelli sottoposti a training preliminare da OpenAI. Per altre informazioni, consultare Creazione di incorporamenti con Azure OpenAI.

Ricerca vettoriale

Per ricerca vettoriale si intende il processo di ricerca di tutti i vettori in un set di dati semanticamente simile a un vettore di query specifico. Pertanto, un vettore di query per la parola human cerca nell’intero dizionario parole semanticamente simili e deve trovare la parola person come corrispondenza stretta. Questa vicinanza o distanza viene misurata usando una metrica di somiglianza, ad esempio la somiglianza del coseno. I vettori più vicini sono in somiglianza; il più piccolo è la distanza tra di essi.

Si consideri uno scenario in cui si esegue una query su milioni di documenti per trovare nei dati a disposizione quelli più simili. È possibile creare incorporamenti per i dati ed eseguire query sui documenti usando Azure OpenAI. Dopodiché, si può eseguire una ricerca vettoriale per trovare i documenti più simili dal set di dati. Tuttavia, l’esecuzione di una ricerca vettoriale in pochi esempi è semplice, Eseguire la stessa ricerca su migliaia o milioni di punti dati diventa impegnativo. Esistono anche compromessi tra la ricerca completa e i metodi di ricerca basate sull’approssimazione del vicino più prossimo, tra cui latenza, velocità effettiva, accuratezza e costi, che dipendono tutti dai requisiti dell’applicazione.

I vettori nell'Istanze gestite del SQL di Azure possono essere archiviati e interrogati in modo efficiente, come descritto nelle sezioni successive, consentendo la ricerca esatta del nearest neighbor con prestazioni elevate. Non è necessario decidere tra precisione e velocità: è possibile avere entrambi. L’archiviazione di incorporamenti di vettori insieme ai dati in una soluzione integrata riduce al minimo la necessità di gestire la sincronizzazione dei dati e accelera il time-to-market per lo sviluppo di applicazioni IA.

Azure OpenAI

L’incorporamento è il processo di rappresentazione del mondo reale come dati. Testo, immagini o suoni possono essere convertiti in incorporamenti. I modelli OpenAI di Azure sono in grado di trasformare le informazioni del mondo reale in incorporamenti. I modelli sono disponibili come endpoint REST e quindi possono essere usati facilmente da Istanza SQL Gestita di Azure usando la procedura di archiviazione di sistema sp_invoke_external_rest_endpoint.

DECLARE @retval INT, @response NVARCHAR(MAX);

DECLARE @payload NVARCHAR(MAX);

SET @payload = JSON_OBJECT('input': @text);

EXEC @retval = sp_invoke_external_rest_endpoint @url = 'https://<openai-url>/openai/deployments/<model-name>/embeddings?api-version=2023-03-15-preview',

@method = 'POST',

@credential = [https://<openai-url>/openai/deployments/<model-name>],

@payload = @payload,

@response = @response OUTPUT;

SELECT CAST([key] AS INT) AS [vector_value_id],

CAST([value] AS FLOAT) AS [vector_value]

FROM OPENJSON(JSON_QUERY(@response, '$.result.data[0].embedding'));

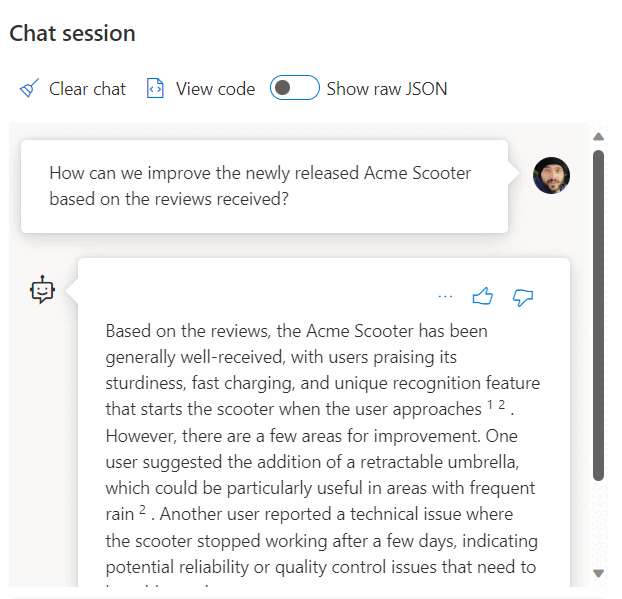

L'uso di una chiamata a un servizio REST per ottenere incorporamenti è solo una delle opzioni di integrazione disponibili quando si usa Istanza gestita di SQL e OpenAI. È possibile consentire a qualsiasi modello disponibile di accedere ai dati archiviati in Istanza gestita di SQL di Azure per creare soluzioni in cui gli utenti possono interagire con i dati, ad esempio l'esempio seguente:

Per altri esempi sull'uso di Azure SQL e OpenAI, vedere gli articoli seguenti:

- Generare immagini con il servizio Azure OpenAI (DALL-E) e Azure SQL

- Uso di endpoint REST OpenAI con Azure SQL

Esempi di vettori

Il tipo di dati vettoriale dedicato consente l'archiviazione efficiente e ottimizzata dei dati vettoriali e include un set di funzioni che consentono agli sviluppatori di semplificare l'implementazione di ricerca vettoriale e di somiglianza. Il calcolo della distanza tra due vettori può essere eseguito in una riga di codice usando la nuova VECTOR_DISTANCE funzione. Per altre informazioni ed esempi, vedere Indici vettoriali e di ricerca vettoriale nel motore di database SQL.

Per esempio:

CREATE TABLE [dbo].[wikipedia_articles_embeddings_titles_vector]

(

[article_id] [int] NOT NULL,

[embedding] [vector](1536) NOT NULL,

)

GO

SELECT TOP(10)

*

FROM

[dbo].[wikipedia_articles_embeddings_titles_vector]

ORDER BY

VECTOR_DISTANCE('cosine', @my_reference_vector, embedding)

Ricerca di intelligenza artificiale di Azure

Implementare modelli RAG con Istanza gestita di SQL di Azure e Ricerca di intelligenza artificiale di Azure. È possibile eseguire modelli di chat supportati sui dati archiviati in Istanza gestita di SQL di Azure, senza dover eseguire il training o ottimizzare i modelli, grazie all'integrazione di Ricerca di intelligenza artificiale di Azure con Azure OpenAI e Istanza gestita di SQL di Azure. L’esecuzione di modelli sui dati consente di chattare e analizzare i dati con maggiore precisione e velocità.

- Azure OpenAI sui tuoi dati

- Generazione aumentata di recupero (RAG) in Azure AI Search

- Ricerca vettoriale con Azure SQL e Ricerca di intelligenza artificiale di Azure

Applicazioni intelligenti

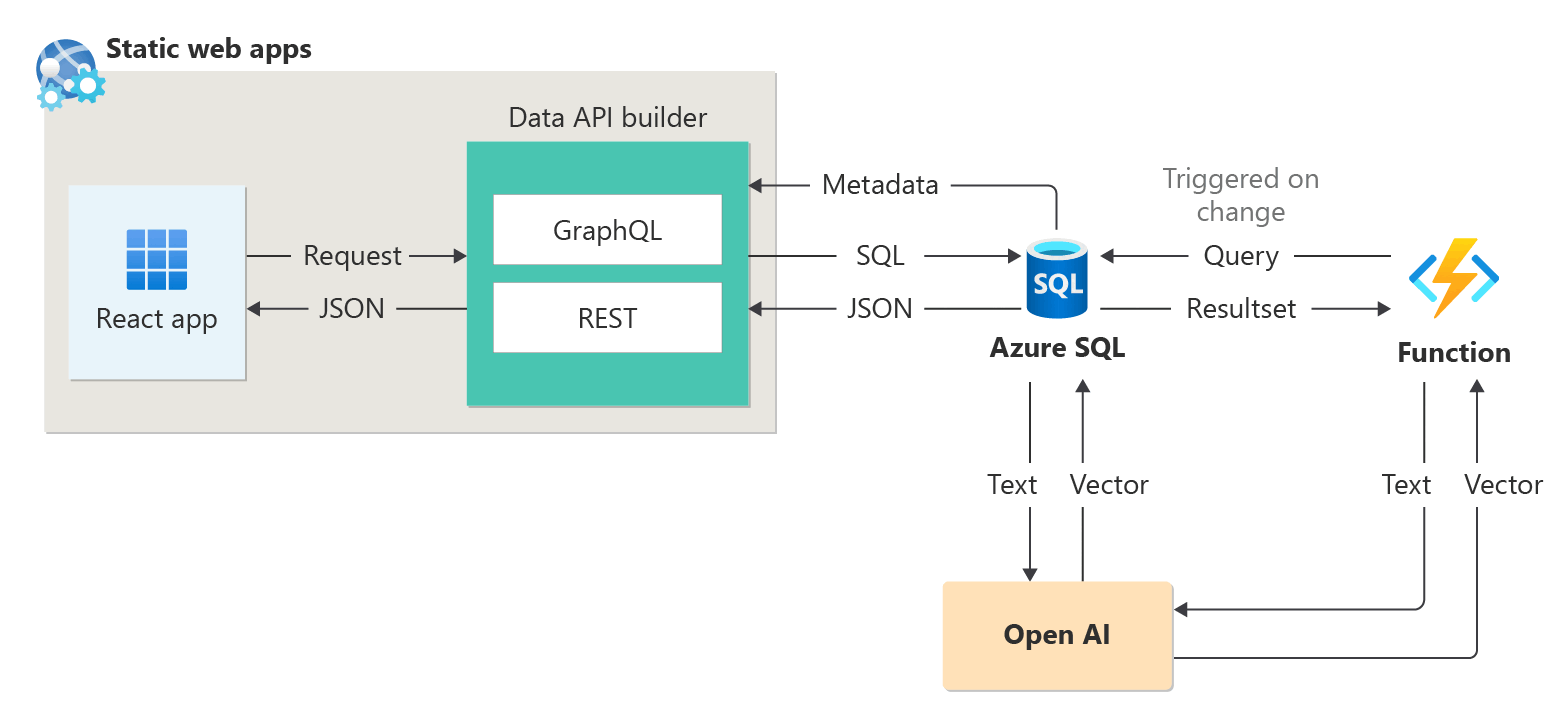

Azure SQL Managed Instance può essere usata per creare applicazioni intelligenti che includono funzionalità di intelligenza artificiale, ad esempio i raccomandatori e Retrieval Augmented Generation (RAG), come mostrato nel diagramma seguente.

Per un esempio end-to-end per creare un'applicazione abilitata per l'intelligenza artificiale usando sessioni astratte come set di dati di esempio, vedere:

- Come è stato creato uno strumento di raccomandazione di sessione in 1 ora usando OpenAI.

- Utilizzo della Retrieval Augmented Generation per creare un assistente di sessione della conferenza

Integrazione di LangChain

LangChain è un noto framework per lo sviluppo di applicazioni basate su modelli linguistici. Per esempi che illustrano come è possibile usare LangChain per creare un chatbot sui propri dati, vedere:

- Pacchetto PyPI langchain-sqlserver

Alcuni esempi sull'uso di Azure SQL con LangChain:

Esempi completi:

- Creare un chatbot sui propri dati in 1 ora con Azure SQL, Langchain e Chainlit: creare un chatbot usando il modello RAG sui propri dati usando Langchain per orchestrare le chiamate LLM e Chainlit per l'interfaccia utente.

Integrazione del kernel semantico

Il kernel semantico è un SDK open source che consente di compilare facilmente agenti che possono chiamare il codice esistente. Come SDK altamente estendibile, è possibile usare il kernel semantico con i modelli di OpenAI, OpenAI di Azure, Hugging Face e altro ancora. Combinando il codice C#, Python e Java esistente con questi modelli, è possibile creare agenti che rispondono a domande e automatizzare i processi.

Di seguito è riportato un esempio di facilità con cui il kernel semantico consente di creare una soluzione abilitata per l'intelligenza artificiale:

- Il chatbot finale?: creare un chatbot sui propri dati usando sia i modelli NL2SQL che RAG per l'esperienza utente finale.